5 Variables aleatorias

Una variable aleatoria sobre una población \(\Omega\) es una función \[ X: \Omega\to \mathbb{R} \] que asigna a cada sujeto de \(\Omega\) un número real. La idea intuitiva tras esta definición es que una variable aleatoria mide una característica de los sujetos de \(\Omega\) que varía al azar de un sujeto a otro. Por ejemplo:

Tomamos una persona de una población y medimos su nivel de colesterol, o su altura, o su número de hijos… En este caso, \(\Omega\) es la población bajo estudio, de la que tomamos la persona que medimos.

Lanzamos una moneda equilibrada 3 veces y contamos las caras que obtenemos. En este caso, \(\Omega\) es la población virtual de las secuencias de 3 lanzamientos de una moneda equilibrada.

Procurad adquirir la disciplina de describir siempre las variables aleatorias mediante una plantilla del estilo de “Tomamos … y medimos …”, para que os quede claro cuál es la unidad muestral, la población y las unidades de medición si es necesario. Por ejemplo:

- “Tomamos una persona de Mallorca y medimos su altura (en cm)”.

Fijaos en que esta variable aleatoria no es la misma que

- “Tomamos una persona de Mallorca y medimos su altura (en m)”

porque, aunque mide lo mismo sobre los mismos sujetos, les asigna números diferentes. Y también es diferente de

- “Tomamos una persona de Suecia y medimos su altura (en cm)”

porque ha cambiado la población.

En cambio en

- “Lanzamos una moneda 3 veces al aire y contamos las caras”

no hay necesidad de especificar unidades, a no ser que vayáis a usar una unidad inesperada (yo qué sé, que contéis las caras en fracciones de docena).

Lo que más nos interesará de una variable aleatoria son las probabilidades de los sucesos que define. ¿Y qué tipo de sucesos son los que nos interesan cuando medimos características numéricas? Pues básicamente sucesos definidos mediante igualdades y desigualdades. Por ejemplo, si \(X\) es la variable aleatoria “Tomamos una persona y medimos su nivel de colesterol en plasma (en mg/dl)”, nos pueden interesar sucesos del estilo de:

El conjunto de las personas cuyo nivel de colesterol está entre 200 y 240. Lo denotaremos \[ 200\leqslant X\leqslant 240 \]

El conjunto de las personas cuyo nivel de colesterol es menor o igual que 200: \[ X\leqslant 200 \]

El conjunto de las personas cuyo nivel de colesterol es mayor que 180: \[ X>180 \]

El conjunto de las personas cuyo nivel de colesterol es exactamente 180: \[ X=180 \]

Etc.

Normalmente, de estos sucesos lo que nos interesará será su probabilidad, y entonces usaremos notaciones del estilo de las siguientes:

\(P(200\leqslant X\leqslant 240)\). Esto denota la probabilidad de que una persona tenga el nivel de colesterol entre 200 y 240. Para abreviar, lo leeremos “la probabilidad de que \(X\) esté entre 200 y 240”. Y recordad que nuestras probabilidades son proporciones. Por lo tanto, esta probabilidad es la proporción de personas (de la población \(\Omega\) donde hayamos definido la variable \(X\)) con nivel de colesterol entre 200 y 240.

\(P(X\leqslant 200)\): La probabilidad de que una persona tenga el nivel de colesterol menor o igual que 200; o la probabilidad de que \(X\) sea menor o igual que 200; o la proporción de personas con nivel de colesterol menor o igual que 200…

Etc.

En este contexto, indicaremos normalmente la unión con una o y la intersección con una coma. Por ejemplo, si \(X\) es la variable aleatoria “Lanzamos una moneda 6 veces y contamos las caras”:

\(P(X\leqslant 2\text{ o }X\geqslant 5)\): Probabilidad de sacar como máximo 2 caras o como mínimo 5.

\(P(2\leqslant X, X< 5)\): Probabilidad de sacar un número de caras que sea mayor o igual que 2 y menor que 5; es decir, \(P(2\leqslant X< 5)\).

Dos variables aleatorias \(X,Y\) son independientes cuando, para todos los pares de valores \(a,b\in \mathbb{R}\), los sucesos \[ X\leqslant a, Y\leqslant b \] son independientes, lo que viene a decir intuitivamente que el valor que toma una de ellas sobre un sujeto no influye en la probabilidad del valor que toma la otra.

Recordad que los sucesos \(X\leqslant a\) e \(Y\leqslant b\) son independientes cuando satisfacen las tres condiciones equivalentes siguientes: \[ \begin{array}{l} P(X\leqslant a|Y\leqslant b)=P(X\leqslant a)\\ P(Y\leqslant b|X\leqslant a)=P(Y\leqslant b)\\ P(X\leqslant a, Y\leqslant b)=P(X\leqslant a)\cdot P(Y\leqslant b) \end{array} \]

Por ejemplo, si tomamos una persona y:

\(X\): le pedimos que lance una moneda 3 veces y contamos las caras

\(Y\): medimos su nivel de colesterol en plasma (en mg/dl)

(seguramente) \(X\) e \(Y\) son independientes.

Más en general, unas variables aleatorias \(X_1,X_2,\ldots,X_n\) son independientes cuando, para cualesquiera \(a_1,a_2,\ldots,a_n\in \mathbb{R}\), los sucesos \[ X_1\leqslant a_1, X_2\leqslant a_2,\ldots, X_n\leqslant a_n \] son independientes. Es decir, cuando los valores que toman algunas de estas variables sobre un sujeto nunca influyen en los valores que toman las otras.

Vamos a distinguir dos tipos de variables aleatorias:

Discretas: Sus posibles valores son datos cuantitativos discretos:

- Número de caras en 3 lanzamientos de una moneda

- Número de hijos

- Número de casos nuevos de COVID-19 en un día en Mallorca

Continuas: Sus posibles valores son datos cuantitativos continuos:

- Peso

- Nivel de colesterol en sangre

- Diámetro de un tumor

Empezamos tratando las variables aleatorias discretas.

5.1 Variables aleatorias discretas

5.1.1 Densidad y distribución

Sea \(X: \Omega\to \mathbb{R}\) una variable aleatoria discreta.

Su dominio \(D_X\) es el conjunto de los valores que puede tomar: más concretamente, el conjunto de los \(x\in \mathbb{R}\) tales que \(P(X=x)>0\).

Su función de densidad es la función \(f_X:\mathbb{R}\to [0,1]\) definida por \[ f_X(x)=P(X=x) \] Es decir, la función que asigna a cada \(x\in \mathbb{R}\) la probabilidad de que \(X\) valga \(x\) (la proporción de sujetos de la población en los que \(X\) vale \(x\), la frecuencia relativa del valor \(x\) en el total de la población…).

Su función de distribución es la función \(F_X:\mathbb{R}\to [0,1]\) definida por \[ F_X(x)=P(X\leqslant x) \] Es decir, la función que asigna a cada \(x\in \mathbb{R}\) la probabilidad de que el valor de \(X\) sea \(\leqslant x\) (la proporción de sujetos de la población en los que \(X\) vale \(\leqslant x\), la frecuencia relativa acumulada de \(x\) en el total de la población… También se la suele llamar función de probabilidad acumulada para poner énfasis en esta última interpretación).

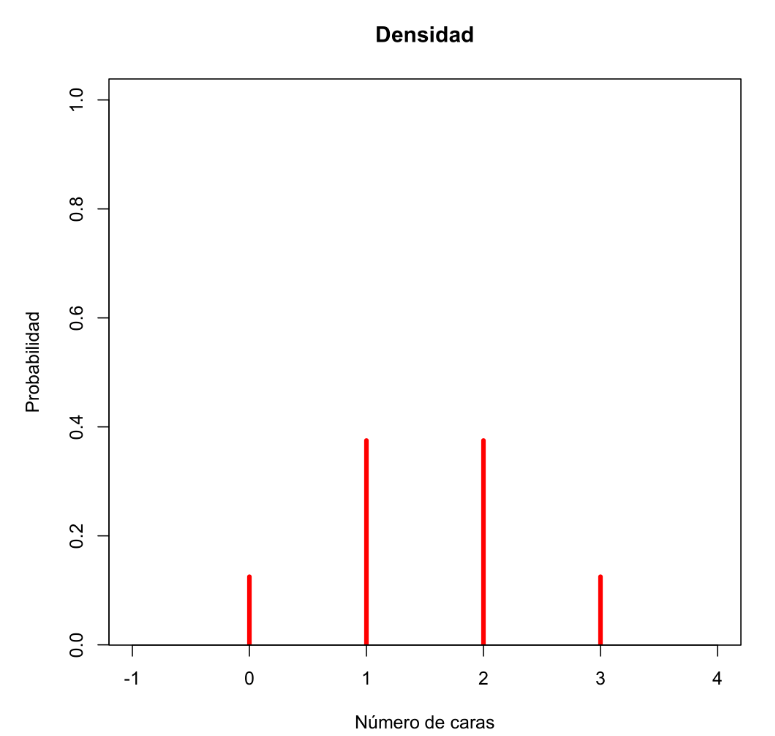

Sea \(X\) la variable aleatoria “Lanzamos 3 veces una moneda equilibrada y contamos las caras”. Entonces

Su dominio es el conjunto de sus posibles valores: \(D_X=\{0,1,2,3\}\).

Su función de densidad viene definida por \(f_X(x)=P(X=x)\):

- \(f_X(0)=P(X=0)=1/8\) (la probabilidad de sacar 0 caras)

- \(f_X(1)=P(X=1)=3/8\) (la probabilidad de sacar 1 cara)

- \(f_X(2)=P(X=2)=3/8\) (la probabilidad de sacar 2 caras)

- \(f_X(3)=P(X=3)=1/8\) (la probabilidad de sacar 3 caras)

- \(f_X(x)=P(X=x)=0\) para cualquier otro valor de \(x\) (la probabilidad de sacar \(x\) caras es 0 si \(x\notin\{0,1,2,3\}\))

En resumen, la función de densidad de \(X\) es \[ f_X(x) =\left\{ \begin{array}{ll} 1/8 & \text{ si $x=0$}\\ 3/8 & \text{ si $x=1$}\\ 3/8 & \text{ si $x=2$}\\ 1/8 & \text{ si $x=3$}\\ 0 & \text{ si $x\neq 0,1,2,3$} \end{array}\right. \]

Si \(X\) es una variable aleatoria discreta, \(P(X\in A)=0\) para cualquier subconjunto \(A\) disjunto de \(D_X\), porque \(X\) no puede tomar ningún valor de \(A\). Por ejemplo, ¿cuál es la probabilidad de sacar entre 2.5 y 2.7 caras al lanzar 3 veces una moneda? 0 ¿Y la de sacar \(\pi\) caras? 0 de nuevo.

Veamos su función de distribución \(F_X\). Recordad que \(F_X(x)=P(X\leqslant x)\) y que nuestra variable solo puede tomar los valores 0, 1, 2 y 3.

Si \(x<0\), \(F_X(x)=P(X\leqslant x)=0\) porque \(X\) no puede tomar ningún valor estrictamente negativo.

Si \(0\leqslant x<1\), el único valor \(\leqslant x\) que puede tomar \(X\) es el 0 y por lo tanto \[ F_X(x)=P(X\leqslant x)=P(X=0)=f_X(0)=1/8 \]

Si \(1\leqslant x<2\), los únicos valores \(\leqslant x\) que puede tomar \(X\) son 0 y 1 y por lo tanto \[ \begin{array}{rl} F_X(x)\!\!\!\!\! & =P(X\leqslant x)=P(X=0\text{ o }X=1)\\ & =f_X(0)+f_X(1)=4/8=1/2 \end{array} \]

Si \(2\leqslant x<3\), los únicos valores \(\leqslant x\) que puede tomar \(X\) son 0, 1 y 2 y por lo tanto \[ \begin{array}{rl} F_X(x)\!\!\!\!\! & =P(X\leqslant x)=P(X=0\text{ o }X=1\text{ o }X=2)\\ & =f_X(0)+f_X(1)+f_X(2)=7/8 \end{array} \]

Si \(x\geqslant 3\), seguro que obtenemos un número de caras \(\leqslant x\) y por lo tanto \(F_X(x)=P(X\leqslant x)=1\).

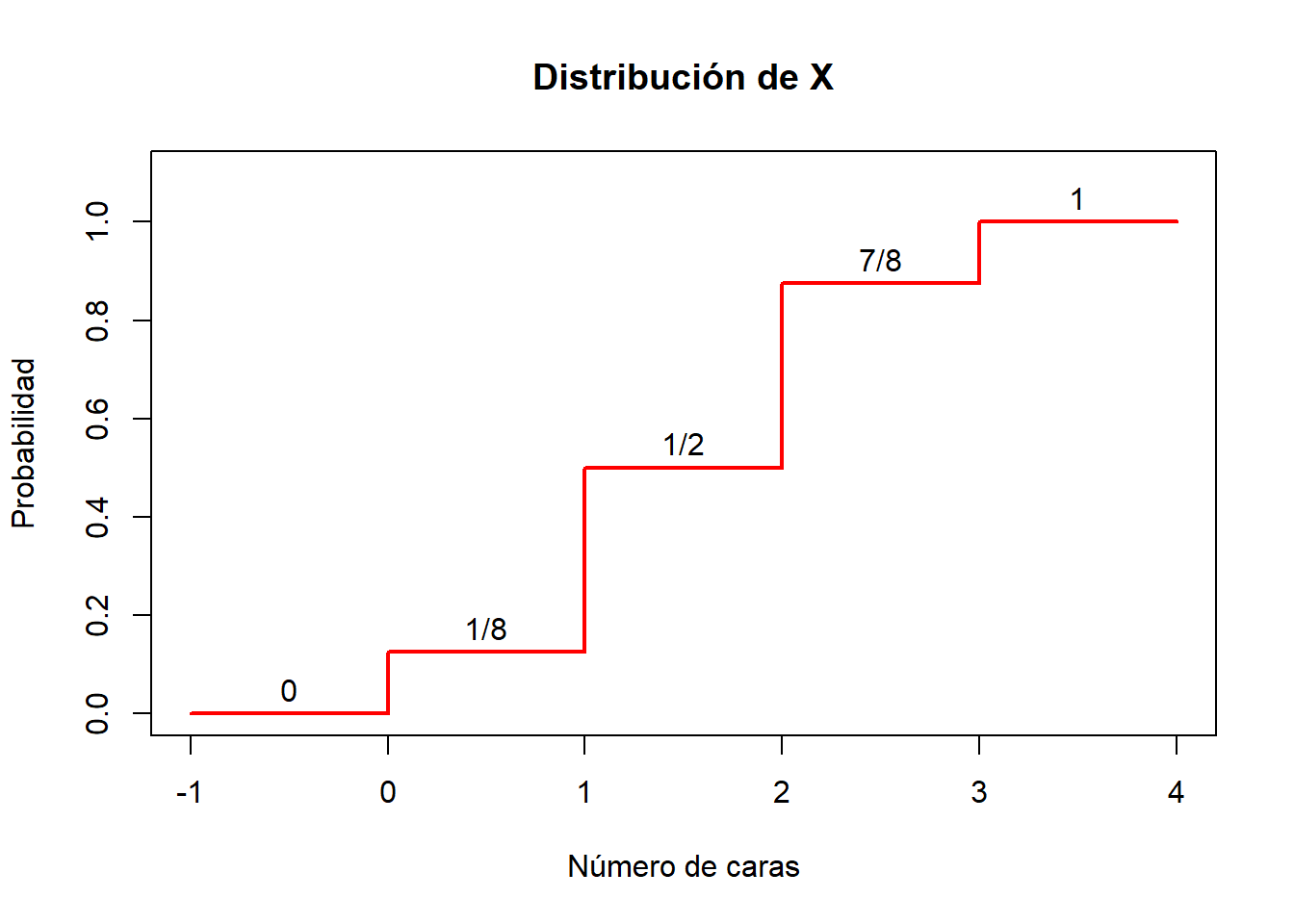

Así pues, la función \(F_X\) es la función \[ F_X(x) =\left\{ \begin{array}{ll} 0 & \text{ si $x<0$}\\ 1/8 & \text{ si $0\leqslant x< 1$}\\ 4/8 & \text{ si $1\leqslant x< 2$}\\ 7/8 & \text{ si $2\leqslant x< 3$}\\ 1 & \text{ si $3\leqslant x$} \end{array}\right. \] Su gráfico es el siguiente:

Observad en este gráfico que esta función de distribución \(F_X\) es creciente y escalonada, y el valor en los puntos de escalón es el superior. Esto es general. Si \(X\) es una variable aleatoria discreta:

\(F_X\) es una función escalonada, con saltos en los valores de \(D_X\), que son los únicos con probabilidad estrictamente mayor que 0 y por lo tanto los únicos que “suman” probabilidad.

\(F_X\) es creciente, porque si \(x\leqslant y\), todos los sujetos tales que \(X\leqslant x\) también cumplen que \(X\leqslant y\), y por lo tanto \[ P(X\leqslant x)\leqslant P(X\leqslant y). \]

Si \(x_0,y_0\in D_X\) y \(x_0<y_0\), entonces \(F_X(x_0)< F_X(y_0)\), porque \[ \begin{array}{rl} F_X(x_0)\!\!\!\!\! & =P(X\leqslant x_0)<P(X\leqslant x_0)+P(X=y_0)\\ & =P(X\leqslant x_0\text{ o }X=y_0)\leqslant P(X\leqslant y_0)=F_X(y_0) \end{array} \]

Como los valores que toma \(F_X\) son probabilidades, no pueden ser ni menores que 0 ni mayores que 1.

El conocimiento de \(f_X\), más las reglas del cálculo de probabilidades, permite calcular la probabilidad de cualquier suceso relacionado con \(X\): \[ P(X\in A) =\sum_{x\in A} P(X=x) = \sum_{x\in A} f_X(x) \] En particular \[ F_X(x_0)=P(X\leqslant x_0)=\sum_{x\leqslant x_0} f_X(x) \]

La moda de una variable aleatoria discreta \(X\) es el valor (o los valores) \(x_0\) tal que \(f_X(x_0)=P(X=x_0)\) es máximo. Se trata por lo tanto del “valor más frecuente de \(X\)” en la población. Por ejemplo, para nuestra variable aleatoria que cuenta el número de caras en 3 lanzamientos de una moneda equilibrada, la moda son los valores 1 y 2.

Hay un aspecto de las variables aleatorias discretas sobre el que queremos llamar la atención, sobre todo por comparación con las variables continuas:

Los valores de \(P(X\leqslant x)\) y \(P(X<x)\) pueden ser diferentes.

De hecho, como \[ P(X\leqslant x)=P(X<x)+P(X=x), \] se tiene que \(P(X< x)\neq P(X\leqslant x)\) exactamente cuando \(x\in D_X\).

Por ejemplo, con la variable \(X\) “Lanzamos una moneda equilibrada 3 veces y contamos las caras”:

La probabilidad de sacar 2 caras o menos ya la hemos calculado, y es \(P(X\leqslant 2)=7/8\)

Pero la probabilidad de sacar menos de 2 caras, \(P(X<2)\), es la de sacar 1 cara o menos, por lo tanto \(P(X<2)=P(X\leqslant 1)=4/8\).

Ejercicio Considerad la variable aleatoria \(X\) “Lanzamos una moneda equilibrada al aire tantas veces como sea necesario hasta que salga una cara por primera vez, y contamos cuántas veces la hemos tenido que lanzar”.

- ¿Cuál es su dominio?

- ¿Cuál es su función de densidad?

- ¿Cuál es su moda? ¿Qué significa?

- ¿Cuál es su función de distribución?

5.1.2 Esperanza

Cuando tomamos una muestra de una variable aleatoria \(X\) definida sobre una población, podemos calcular la media y la desviación típica de sus valores para obtener una idea de cuál es su valor central y de la variabilidad de sus valores. También nos podemos preguntar por este tipo de información para el total de la población: ¿cuál es el “valor medio” de \(X\) sobre toda la población? ¿\(X\) toma valores muy dispersos, o más bien concentrados alrededor de este valor medio? Lo primero lo medimos con la media, o esperanza, de \(X\), y lo segundo con su desviación típica. Empecemos con la primera.

La media, o esperanza (o valor esperado, valor medio, valor promedio…), de una variable aleatoria discreta \(X\) con densidad \(f_X:D_X\to [0,1]\) es \[ E(X)=\sum_{x\in D_X} x\cdot f_X(x) \] A veces también la denotaremos por \(\mu_X\).

La interpretación natural de \(E(X)\) es que es la media de los valores de la variable \(X\) en el total de la población \(\Omega\). En efecto, como \(f_X(x)=P(X=x)\) es la proporción de los sujetos de \(\Omega\) en los que \(X\) vale \(x\), entonces \[ E(X)=\sum_{x\in D_X} x\cdot f_X(x) \] es el promedio del valor de \(X\) sobre todos los elementos de \(\Omega\). Comparadlo con el ejemplo siguiente.

Si, en una clase, un 10% de los estudiantes han sacado un 4 en un examen, un 20% un 6, un 50% un 8 y un 20% un 10, ¿cuál ha sido la nota media del examen?

Suponemos que calcularíais esta media como \[ 4\cdot 0.1+6\cdot 0.2+8\cdot 0.5+10\cdot 0.2=7.6 \] Pues este valor es la media de la variable aleatoria \(X\) “Tomo un estudiante de esta clase y miro qué nota ha sacado en este examen”: \[ \begin{array}{rl} E(X)\!\!\!\!\! &=4\cdot P(X=4)+6\cdot P(X=6)+8\cdot P(X=8)+10\cdot P(X=10)\\ & = 4\cdot 0.1+6\cdot 0.2+8\cdot 0.5+10\cdot 0.2=7.6 \end{array} \]

Aparte de su interpretación como “el promedio de \(X\) en el total de la población”, \(E(X)\) es también el valor esperado de \(X\), en el sentido siguiente:

Suponed que tomamos una muestra aleatoria de \(n\) sujetos de la población, medimos \(X\) sobre ellos y calculamos la media aritmética de los \(n\) valores obtenidos. Entonces, cuando el tamaño \(n\) de la muestra tiende a \(\infty\), esta media aritmética tiende a valer \(E(X)\) “casi seguro” (en el sentido de que la probabilidad de que su límite sea \(E(X)\) es 1).

Aquí probabilidad 1 no significa “total y absolutamente seguro”, porque este límite va a ser una variable aleatoria continua, donde, como veremos en la próxima lección, probabiilidad 0 no significa imposible ni probabilidad 1 significa 100% seguro. Por ejemplo, si repetís muchas veces el proceso de lanzar una moneda equilibrada 3 veces, por pura mala suerte puede pasar que en todas las ocasiones saquéis tres caras. Casi seguro que no pasa, pero no podemos estar 100% seguros de que no pase, no es imposible.

Es decir: si midiéramos \(X\) sobre muchos sujetos elegidos al azar, de media casi seguro que obtendríamos un valor muy próximo a \(E(X)\).

Ejemplo:Seguimos con la variable aleatoria \(X\) “Lanzamos una moneda equilibrada al aire 3 veces y contamos las caras”. Su esperanza es \[ E(X)= 0\cdot \frac{1}{8}+1\cdot \frac{3}{8}+2\cdot \frac{3}{8}+3\cdot \frac{1}{8}=1.5 \]

Esto nos dice que:

La media de \(X\) es 1.5: El valor medio de la variable \(X\) sobre toda la población de secuencias de 3 lanzamientos de una moneda equilibrada es 1.5.

El valor esperado de \(X\) es 1.5: Si repitiésemos muchas veces el experimento de lanzar la moneda 3 veces y contar las caras, la media de los resultados obtenidos daría, muy probablemente, un valor muy cercano a 1.5. Abreviamos esto diciendo que si lanzamos la moneda 3 veces, de media esperamos sacar 1.5 caras.

Más en general, si \(g:\mathbb{R}\to \mathbb{R}\) es una aplicación, el valor esperado de la composición \(\Omega \stackrel{X}{\longrightarrow} \mathbb{R}\stackrel{g}{\longrightarrow}\mathbb{R}\) es \[ E(g(X))=\sum_{x\in D_X} g(x)\cdot f_X(x) \] De nuevo, su interpretación natural es que es el promedio de \(g(X)\) sobre la población en la que medimos \(X\), y también es el valor “esperado” de \(g(X)\) en el sentido anterior.

Ejemplo:Si lanzamos una moneda equilibrada al aire 3 veces, contamos las caras y elevamos este número de caras al cuadrado, ¿qué valor esperamos obtener, de media? Será la esperanza de \(X^2\), siendo \(X\) la variable aleatoria “Lanzamos una moneda equilibrada al aire 3 veces y contamos las caras” (o sea, \(X^2\) es la variable aleatoria “Lanzamos una moneda equilibrada al aire 3 veces, contamos las caras y elevamos este número al cuadrado”):

\[ E(X^2)= 0\cdot \frac{1}{8}+1\cdot \frac{3}{8}+2^2\cdot \frac{3}{8}+3^2\cdot \frac{1}{8}=3 \]

En los dos últimos ejemplos hemos visto que si \(X\) es la variable aleatoria que cuenta el número de caras en 3 lanzamientos de una moneda equilibrada, \(E(X^2)=3\) pero \(E(X)^2=1.5^2=2.25\). Por lo tanto, puede pasar que \(E(X^2) \neq E(X)^2\). De hecho, es lo más común.

Más en general, dada una aplicación \(g:\mathbb{R}\to \mathbb{R}\), lo usual es que \(E(g(X))\neq g(E(X))\).

La esperanza de las variables aleatorias discretas tiene las propiedades siguientes, todas razonables si las interpretáis en términos del valor promedio de \(X\) sobre la población:

Sea \(b\) una variable aleatoria constante, que sobre todos los individuos de la población toma el mismo valor \(b\in \mathbb{R}\). Entonces \(E(b)=b\).

Si en una clase todo el mundo saca un 8 de un examen, la nota media es 8, ¿no?

La esperanza es lineal:

Si \(a,b\in \mathbb{R}\), \(E(aX+b)=aE(X)+b\)

Si en una clase la media de un examen ha sido un 6 y decidimos multiplicar por 1.2 todas las notas y sumarles 1 punto, la nueva nota media será 1.2·6+1=8.2, ¿no?

Si \(Y\) es otra variable aleatoria, \(E(X+Y)=E(X)+E(Y)\).

Si en una clase la media de la parte de cuestiones de un examen ha sido un 3.5 (sobre 5) y la de la parte de ejercicios ha sido un 3 (sobre 5) y la nota del examen es la suma sus dos partes, la nota media del examen será un 3.5+3=6.5, ¿no?

Más en general, si \(X_1,\ldots,X_n\) son variables aleatorias y \(a_1,\ldots,a_n,b\in \mathbb{R}\), \[ E(a_1X_1+\cdots +a_nX_n+b)=a_1E(X_1)+\cdots +a_nE(X_n)+b \]

La esperanza es monótona creciente: Si \(X\leqslant Y\) (en el sentido de que, para cada sujeto de la población \(\Omega\), su valor de \(X\) es menor o igual que su valor de \(Y\)), entonces \(E(X)\leqslant E(Y)\).

Si todos sacáis mejor nota de Anatomía que de Bioestadística, la nota media de Anatomía será mayor que la de Bioestadística, ¿no?

5.1.3 Varianza y desviación típica

La varianza de una variable aleatoria discreta \(X\) es \[ \sigma^2(X) =E((X-\mu_X)^2) =\sum_{x\in D_X} (x-\mu_X)^2\cdot f_X(x) \] Es decir, es el valor medio del cuadrado de la diferencia entre \(X\) y su media \(\mu_X\). También la denotaremos \(\sigma_X^2\).

Fijaos en que se trata de la traducción “poblacional” de la definición de varianza para una muestra, y por lo tanto sirve para medir lo mismo que aquella: la dispersión de los resultados de \(X\) respecto de la media. Solo que ahora para toda la población.

La identidad siguiente os puede ser útil para calcular varianzas “a mano”. Ya vimos en la lección anterior esta igualdad para la varianza de una muestra.

\[\sigma^2(X)=E(X^2)-\mu_X^2\].

Operemos (y recordad que \(E(X)=\mu_X\)) \[ \begin{array}{rl} \sigma^2(X)\!\!\!\!\! & =E((X-\mu_X)^2)=E(X^2-2\mu_X\cdot X+\mu_X^2)\\ & = E(X^2)-2\mu_X\cdot E(X)+\mu_X^2\\ & \text{(por la linealidad de $E$)}\\ & = E(X^2)-2\mu_X^2+\mu_X^2=E(X^2)-\mu_X^2 \end{array} \]

:::{.callout note} En particular, si \(X\) no es una variable constante, \(\sigma^2(X)\) es una suma de cuadrados, algunos de los cuales va a ser diferente de 0 y por lo tanto estrictamente positivo, en cuyo caso \(E(X^2)-\mu_X^2=\sigma^2(X)>0\): el valor esperado de \(X^2\) es mayor que el cuadrado del valor esperado de \(X\). :::

La desviación típica (o desviación estándar) de una variable aleatoria discreta \(X\) es la raíz cuadrada positiva de su varianza: \[ \sigma(X)=+\sqrt{\sigma^2(X)} \] También mide la dispersión de los valores de \(X\) respecto de la media. La denotaremos a veces por \(\sigma_X\).

El motivo para introducir la varianza y la desviación típica para medir la dispersión de los valores de \(X\) es la misma que en estadística descriptiva: la varianza es más fácil de manejar (no involucra raíces cuadradas) pero sus unidades son las de \(X\) al cuadrado, mientras que las unidades de la desviación típica son las de \(X\), y por lo tanto su valor es más fácil de interpretar.

Ejemplo:Seguimos con la variable aleatoria \(X\) “Lanzamos una moneda equilibrada 3 veces y contamos las caras”. Su varianza es:

\[ \begin{array}{rl} \sigma^2(X) \!\!\!\!\! & \displaystyle=(0-1.5)^2\cdot \frac{1}{8}+(1-1.5)^2\cdot \frac{3}{8}\\ &\displaystyle\qquad +(2-1.5)^2\cdot \frac{3}{8}+(3-1.5)^2\cdot \frac{1}{8}=0.75 \end{array} \] Si recordamos que \(\mu_X=E(X)=1.5\) y \(E(X^2)=3\), podemos ver que \[ E(X^2)-\mu_X^2=3-1.5^2=0.75=\sigma^2(X) \] Su desviación típica es \[ \sigma(X) =\sqrt{\sigma^2(X)}=\sqrt{0.75}= 0.866 \]

Veamos algunas propiedades de la varianza y la desviación típica:

- Si \(b\) es una variable aleatoria constante que sobre todos los individuos de la población toma el valor \(b\in \mathbb{R}\), es decir, tal que \(D_b=\{b\}\), entonces \(\mu_b=b\) y \(\sigma(b)^2=(b-b)f_b(b)=0\)..

Una variable aleatoria constante tiene cero dispersión, ¿no?

El recíproco también es cierto:

Si \(0=\sigma^2(X)=\sum_{x\in D_X} (x-\mu_X)^2\cdot f_X(x)\), entonces todos los sumandos son 0, y como \(f_X(x)\neq 0\) si \(x\in D_X\), concluimos que, para todo \(x\in D_X\), \(x=\mu_X\): es decir, que el dominio está formado por un solo número y la variable aleatoria es constante.

- \(\sigma(aX+b)^2=a^2\cdot \sigma^2(X)\).

En efecto \[ \begin{array}{l} \sigma(aX+b)^2 =E((aX+b)^2)-E(aX+b)^2\\ \quad = E(a^2X^2+2abX+b^2)-(aE(X)+b)^2\\ \quad \text{(por la linealidad de $E$)}\\ \quad = a^2E(X^2)+2abE(X)+b^2-a^2E(X)^2-2abE(X)-b^2\\ \quad \text{(de nuevo, por la linealidad de $E$)}\\ \quad = a^2(E(X^2)-E(X)^2)=a^2\sigma^2(X) \end{array} \]

Sumar un valor constante \(b\) a una variable aleatoria no modifica su dispersión: si en un examen a todos los estudiantes les sumamos 1 punto, la media va a subir 1 punto pero la dispersión de las notas alrededor de esta media va a ser la misma que antes de sumarlo.

\(\sigma(aX+b)=|a|\cdot \sigma(X)\) (recordad que la desviación típica es positiva y que \(+\sqrt{a^2}=|a|\)).

Si \(X,Y\) son variables aleatorias independientes, \[ \sigma(X+Y)^2=\sigma^2(X)+\sigma(Y)^2 \] y por lo tanto \[ \sigma(X+Y)=\sqrt{\sigma^2(X)+\sigma(Y)^2} \] Si no son independientes, en general esta igualdad es falsa. Por poner un ejemplo extremo, \[ \sigma(X+X)^2=4\sigma^2(X)\neq \sigma^2(X)+\sigma^2(X). \]

Más en general, si \(X_1,\ldots,X_n\) son variables aleatorias independientes y \(a_1,\ldots,a_n,b\in \mathbb{R}\), \[ \sigma(a_1X_1+\cdots +a_nX_n+b)^2=a_1^2\sigma(X_1)^2+\cdots +a_n^2\sigma(X_n)^2 \]

5.1.4 Cuantiles

Sea \(p\) tal que \(0<p<1\). El cuantil de orden \(p\) (o \(p\)-cuantil) de una variable aleatoria \(X\) discreta es el menor valor \(x_p\) de su dominio \(D_X\) tal que \(P(X\leqslant x_p)\geqslant p\); es decir, es el valor \(x_p\in D_X\) tal que \(P(X\leqslant x_p)\geqslant p\) pero \(P(X< x_p)<p\).

Por ejemplo, que el 0.25-cuantil de una variable aleatoria discreta \(X\) sea, pongamos, 8, significa que 8 es el menor valor del dominio de \(X\) tal que su probabilidad acumulada llega a (o pasa de) 0.25. En otras palabras, que al menos una cuarta parte de la población tiene un valor de \(X\) menor o igual que 8, pero estrictamente menos de un 25% de la población tiene un valor de \(X\) estrictamente menor que 8.

Si existe algún \(x_p\in D_X\) tal que \(F_X(x_p)(=P(X\leqslant x_p))=p\), entonces el \(p\)-cuantil es ese \(x_p\), porque si \(x<x_p\), \(P(X\leqslant x)<P(X\leqslant x_p)=F_X(x_p)=p\) y por lo tanto es el menor elemento del dominio con probabilidad acumulada al menos (en este caso, exactamente) \(p\).

Como en estadística descriptiva, algunos cuantiles de variables aleatorias tienen nombres propios. Por ejemplo:

La mediana de \(X\) es su 0.5-cuantil

El primer y el tercer cuartiles de \(X\) son sus \(0.25\)-cuantil y \(0.75\)-cuantil, respectivamente.

Etc.

Seguimos con la variable aleatoria \(X\) “Lanzamos una moneda equilibrada 3 veces y contamos las caras”. Recordemos que su función de distribución es

\[ F_X(x)=\left\{ \begin{array}{ll} 0 & \text{ si $x<0$}\\ 0.125 & \text{ si $0\leqslant x<1$}\\ 0.5 & \text{ si $1\leqslant x<2$}\\ 0.875 & \text{ si $2\leqslant x<3$}\\ 1 & \text{ si $3\leqslant x $} \end{array} \right. \]

Entonces, por ejemplo:

Su 0.1-cuantil es 0

Su 0.25-cuantil es 1

Su mediana es 1

Su 0.75-cuantil es 2

Aunque usamos “media”, “varianza”, “cuantiles”, etc. tanto para muestras como para variables aleatorias, no debéis confundirlas.

Una variable aleatoria representa una característica númerica de los sujetos de una población. Por ejemplo:

“Tomamos un estudiante de farmacia y medimos su altura en m.”

La media y la varianza de esta variable son las de toda la población de estudiantes de farmacia.

Una muestra de una variable aleatoria son los valores de la misma sobre un subconjunto (relativamente pequeño) de la población. Por ejemplo:

Medimos las alturas (en m) de 50 estudiantes de farmacia de este curso.

La media y la varianza de esta muestra son solo las de esas 50 alturas.

Cuando queramos destacar que una media, una varianza etc. son las de una variable aleatoria y por lo tanto refieren a toda una población, los calificaremos de poblacionales.

5.2 Familias importantes de variables aleatorias discretas

Vamos a describir tres familias de variables aleatorias “distinguidas” que tenéis que conocer:

- Binomial

- Hipergeométrica

- Poisson

Cada una de estas familias tienen un tipo específico de función de densidad, que depende de uno o varios parámetros.

De estas familias de variables tenéis que saber:

- Distinguirlas: saber cuando una variable aleatoria es de una de estas familias.

- Sus propiedades más básicas, como por ejemplo cuáles son sus parámetros, cuál es su valor esperado y si su densidad es simétrica o presenta una cola a algún lado.

- Usar algún programa o alguna aplicación para calcular cosas con ellas cuando sea necesario.

5.2.1 Variables aleatorias binomiales

Un experimento de Bernoulli es una acción con solo dos posibles resultados, que identificamos con “Éxito” (\(E\)) y “Fracaso” (\(F\)). Por ejemplo, lanzar un dado cúbico y mirar si ha salido un 6 (\(E\): sacar un 6; \(F\): cualquier otro resultado). La probabilidad de éxito \(p\) de un experimento de Bernoulli es la probabilidad de obtener \(E\). Es decir, \(P(E)=p\). Naturalmente, entonces, \(P(F)=1-p\). En el ejemplo del dado, donde \(E\) es sacar un 6, \(p=1/6\).

Otros ejemplos de experimentos de Bernoulli:

Lanzar una moneda equilibrada y mirar si da cara:

- \(E\): Sacar cara

- \(p=1/2\)

Realizar un test PCR de COVID-19 a una persona y mirar si da positivo:

- \(E\): Dar positivo

- \(p\): La proporción de personas que dan positivo en el test (su tasa de positividad).

Una variable aleatoria de Bernoulli de parámetro \(p\) (abreviadamente, \(Be(p)\)) es una variable aleatoria \(X\) consistente en efectuar un experimento de Bernoulli y dar 1 si se ha obtenido un éxito y 0 si se ha obtenido un fracaso.

Una variable aleatoria binomial de parámetros \(n\) y \(p\) (abreviadamente, \(B(n,p)\)) es una variable aleatoria \(X\) que cuenta el número de éxitos \(E\) en una secuencia de \(n\) repeticiones independientes de un mismo experimento de Bernoulli de probabilidad de éxito \(p\). Independientes significa que las \(n\) variables aleatorias de Bernoulli, una para cada repetición del experimento de Bernoulli, son independientes; intuitivamente, que el resultado de cada repetición en la secuencia no depende de los resultados de las otras.

Llamaremos a \(n\) el tamaño de las muestras y a \(p\) la probabilidad (poblacional) de éxito. A veces también diremos de una variable \(X\) de tipo \(B(n,p)\) que tiene distribución binomial de parámetros \(n\) y \(p\).

Por ejemplo:

Una variable de Bernoulli \(Be(p)\) es una variable binomial \(B(1,p)\).

Lanzar una moneda equilibrada 10 veces y contar las caras es una variable binomial \(B(10,0.5)\)

Elegir 20 personas al azar, una tras otra, permitiendo repeticiones y de manera independiente las unas de las otras, realizar sobre ellas un test PCR de COVID-19 y contar cuántos dan positivo, es una variable binomial \(B(20,p)\) con \(p\) la tasa de positividad del test.

Tenemos el resultado siguiente.

Teorema: Si \(X\) es una variable \(B(n,p)\):

Su dominio es \(D_X=\{0,1,\ldots,n\}\)

Su función de densidad es \[ f_X(k)=\left\{\begin{array}{ll} \displaystyle\binom{n}{k}p^k(1-p)^{n-k} & \text{ si $k\in D_X$}\\ 0 & \text{ si $k\notin D_X$} \end{array}\right. \]

Su valor esperado es \(E(X)=np\)

Su varianza es \(\sigma^2(X)=np(1-p)\)

Recordad que:

El factorial \(m!\) de un número natural \(m\) se define como \(m!=m(m-1)\cdots 2\cdot 1\) si \(m\geqslant 1\). Si \(m=0\), se toma \(0!=1\).

El número combinatorio \(\binom{n}{k}\) se define como \[ \binom{n}{k}=\frac{\overbrace{n\cdot (n-1)\cdots (n-k+1)}^k}{k\cdot (k-1)\cdots 2\cdot 1}=\frac{n!}{k!(n-k)!} \] y nos da el número de subconjuntos de \(k\) elementos de \(\{1,\ldots,n\}\).

Si lo pensáis, veréis que el valor de \(E(X)\) es el “esperado”. Si tomáis una muestra aleatoria de \(n\) sujetos de una población en la que la proporción de sujetos \(E\) es \(p\), ¿cuántos sujetos \(E\) “esperáis” obtener en vuestra muestra? Pues una fracción \(p\) de la muestra, es decir \(p\cdot n\), ¿no?

Para calcular el valor esperado y la varianza se suman \[ \begin{array}{l} \displaystyle E(X)=\sum_{k=0}^n k\cdot \binom{n}{k}p^k(1-p)^{n-k}\\ \displaystyle \sigma^2(X)=\sum_{k=0}^n k^2\cdot \binom{n}{k}p^k(1-p)^{n-k}-\Big(\sum_{k=0}^n k\cdot \binom{n}{k}p^k(1-p)^{n-k}\Big)^2 \end{array} \] Os podéis fiar de nosotros, dan \(np\) y \(np(1-p)\), respectivamente.

El tipo de teorema anterior es el que hace que nos interese conocer algunas familias distinguidas frecuentes de variables aleatorias. Si, por ejemplo, reconocemos que una variable aleatoria es binomial y conocemos sus valores de \(n\) y \(p\) y sabemos el teorema anterior (o sabemos dónde consultarlo), automáticamente sabemos su función de densidad, y con ella su función de distribución, su valor esperado, su varianza etc., sin necesidad de deducir toda esta información cada vez que encontremos una variable de estas.

El conocimiento ahorra tiempo.

Conocer las propiedades de las variables aleatorias binomiales solo es útil si sabemos reconocer cuándo estamos ante una de ellas. Fijaos en que en una variable aleatoria binomial \(B(n,p)\):

Contamos cuántas veces ocurre un suceso (el éxito \(E\)) en una secuencia de intentos.

En cada intento, el suceso que nos interesa pasa o no pasa, sin términos medios.

El número de intentos es fijo, \(n\).

Cada intento es independiente de los otros.

En cada intento, la probabilidad de que pase el suceso que nos interesa es siempre la misma, \(p\).

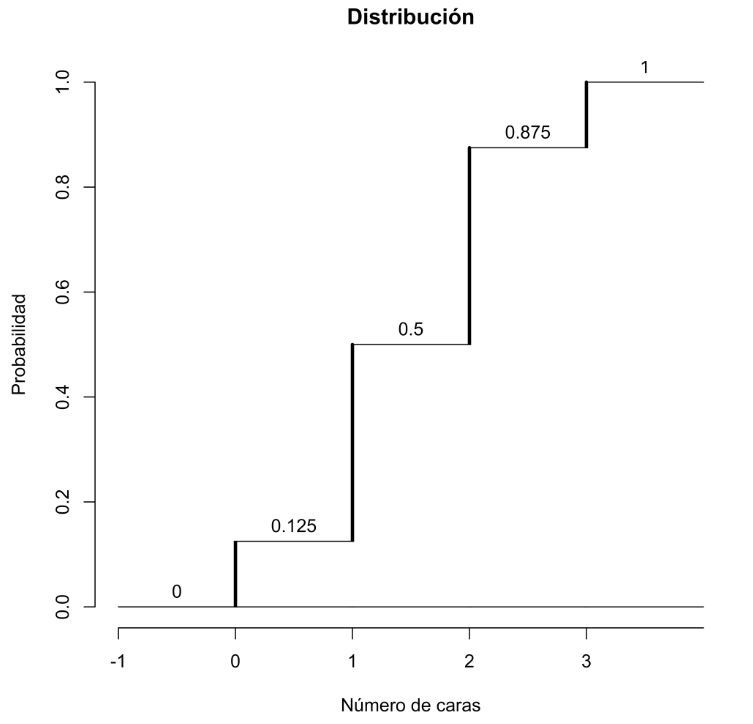

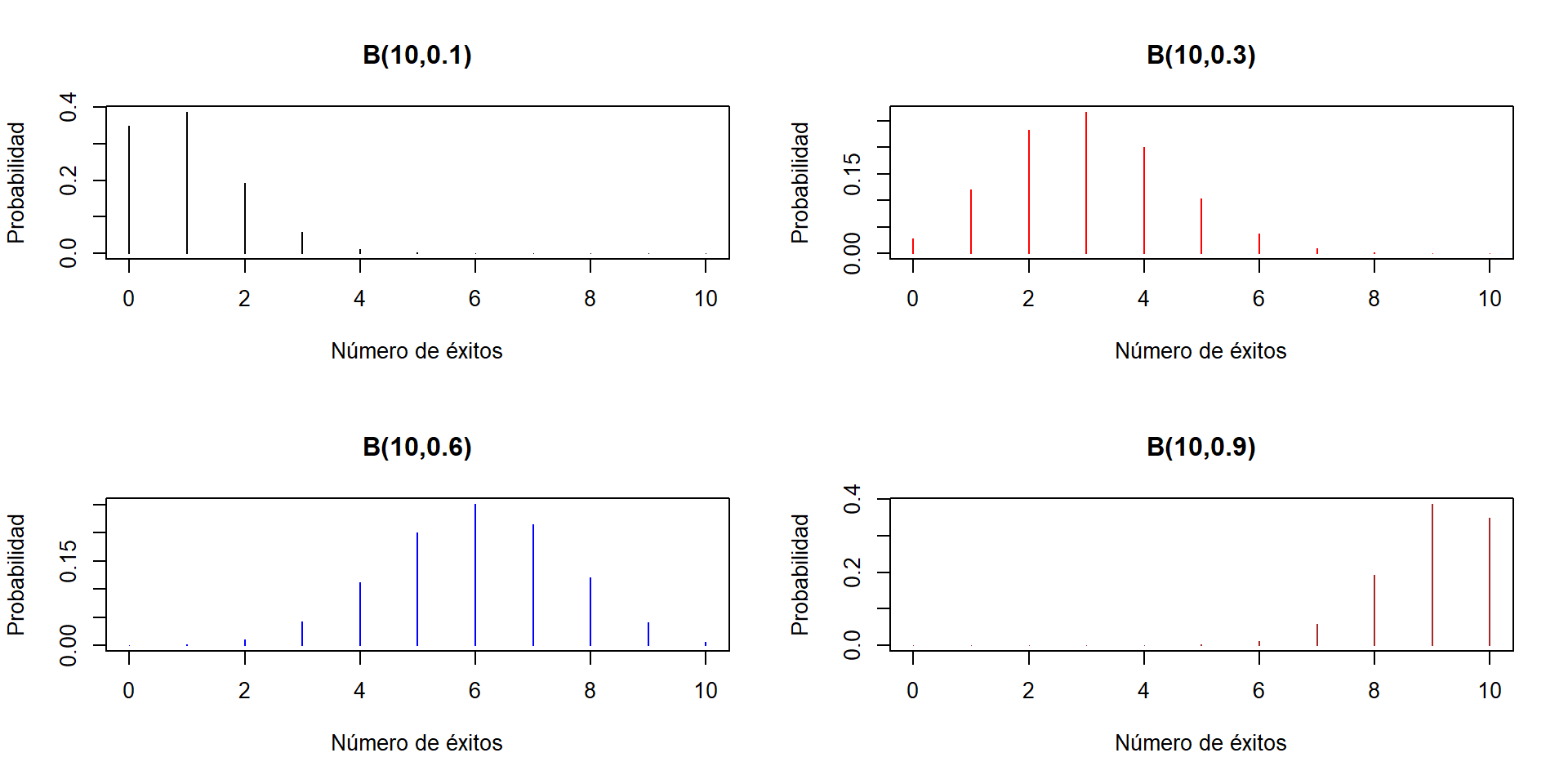

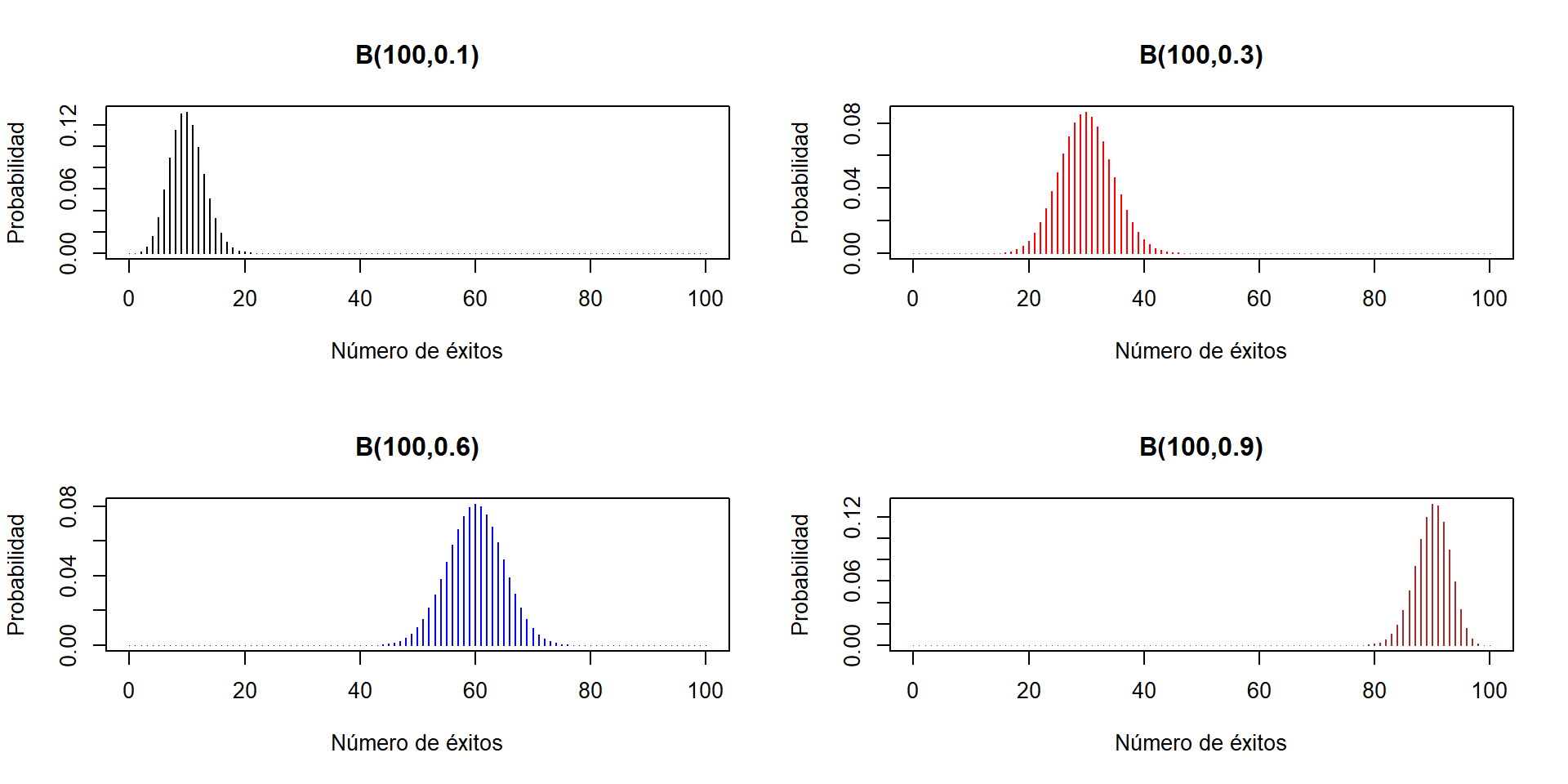

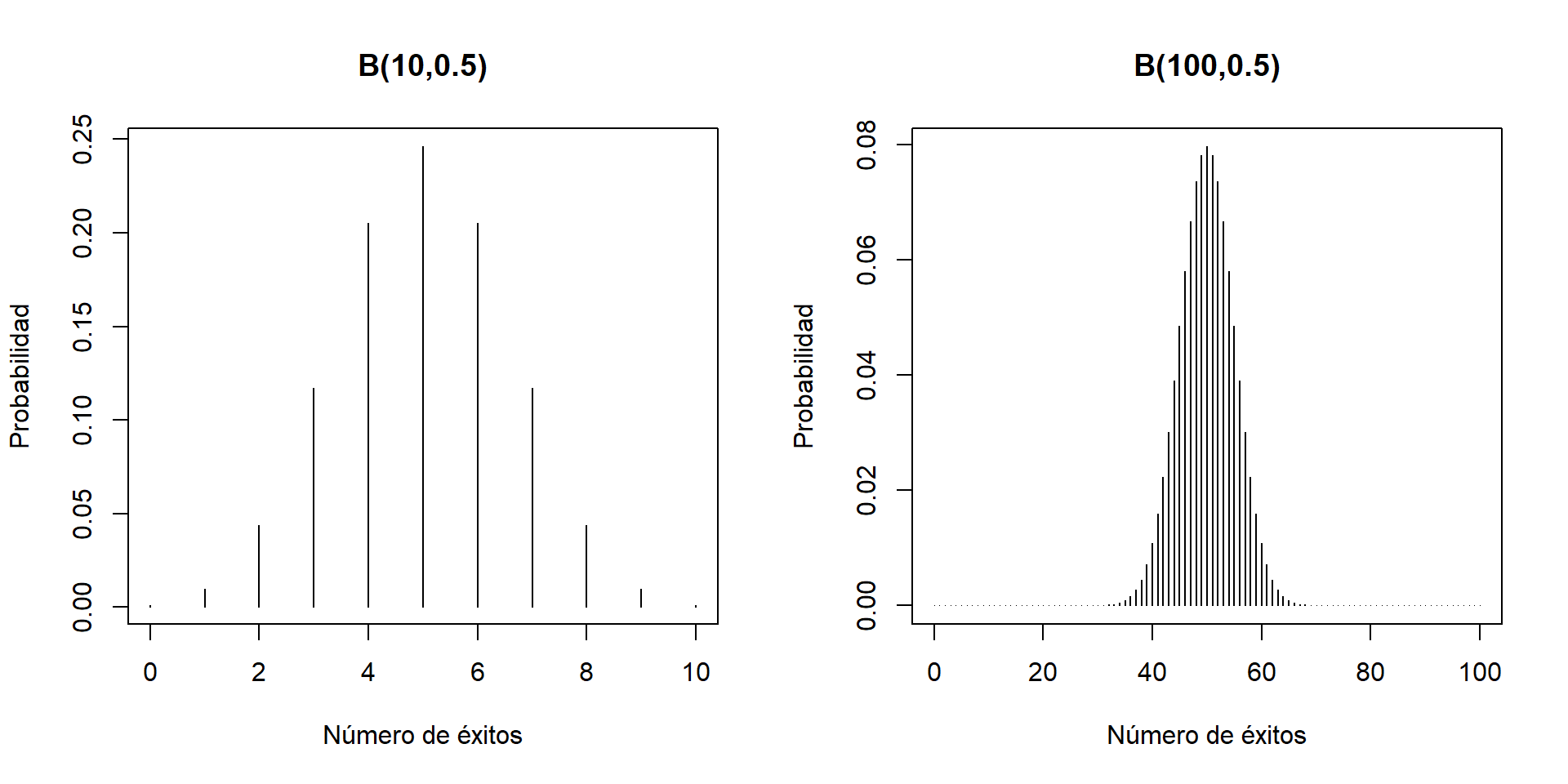

Veamos algunos gráficos de la función densidad de variables aleatorias binomiales. Primero, para \(n=10\) y diferentes valores de \(p\).

Ahora para \(n=100\):

Podréis observar que si \(p<0.5\), la distribución \(B(n,p)\) presenta una cola a la derecha, y si \(p>0.5\), la cola es a la izquierda. Es razonable. Por ejemplo, si \(p<0.5\), el valor esperado será \(pn<n/2\) y hay más valores posibles a la derecha de \(pn\) que a su izquierda (porque una binomial \(B(n,p)\) puede llegar a tomar el valor \(n\), pero no puede tomar valores negativos).

Si \(p=0.5\), es simétrica: como \(E\) y \(F\) tienen la misma probabilidad, 0.5, la probabilidad de sacar \(k\) \(E\)’s es la misma que la de sacar \(k\) \(F\)’s, es decir, la de sacar \(n-k\) \(E\)’s.

¿Cómo efectuar cálculos con una variable aleatoria de una familia dada?

Una posibilidad es usar una aplicación de móvil o tablet. Nuestra favorita es Probability distributions, disponible tanto para Android como para iOS.

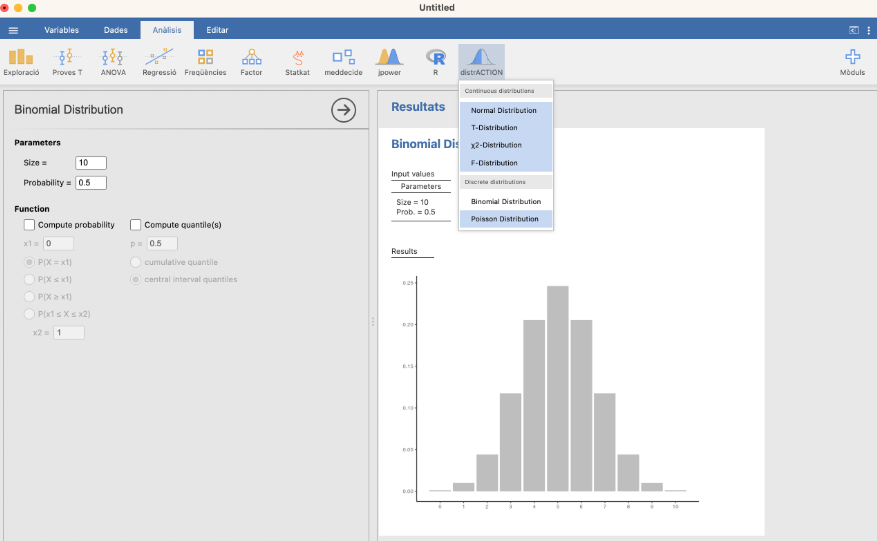

Otra posibilidad es usar JAMOVI. El módulo distrACTION permite calcular probabilidades y cuantiles de todas las distribuciones que usaremos en este curso salvo una, la hipergeométrica. Ya hablaremos de ella en la próxima sección.

Por ejemplo:

Si lanzamos 20 veces un dado equilibrado (de 6 caras), ¿cuál es la probabilidad de sacar exactamente 5 unos?

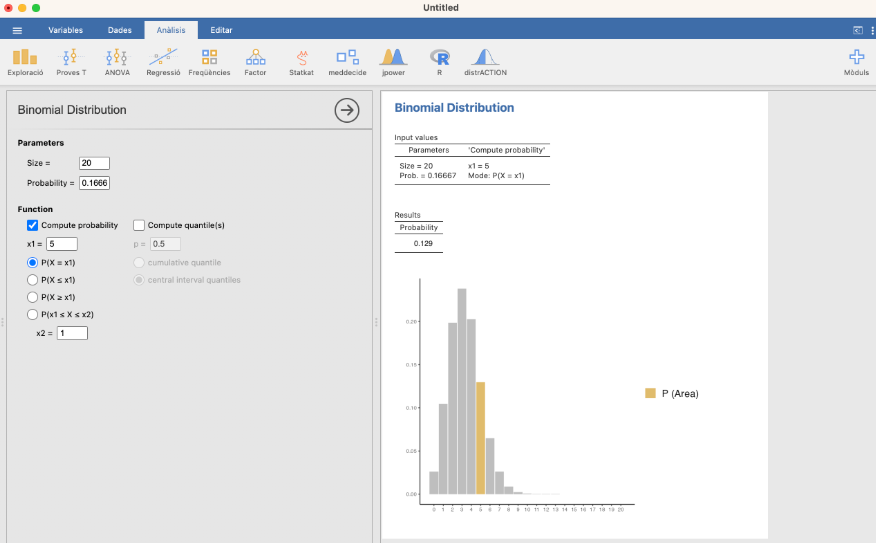

Si llamamos \(X\) a la variable aleatoria que cuenta el número de unos en secuencias de 20 lanzamientos de un dado equilibrado, se trata de una variable binomial \(B(20,1/6)=B(20,0.166667)\). Nos piden \(P(X=5)\). Da 0.129:

Si lanzamos 20 veces un dado equilibrado, ¿cuál es la probabilidad de sacar como máximo 5 unos?

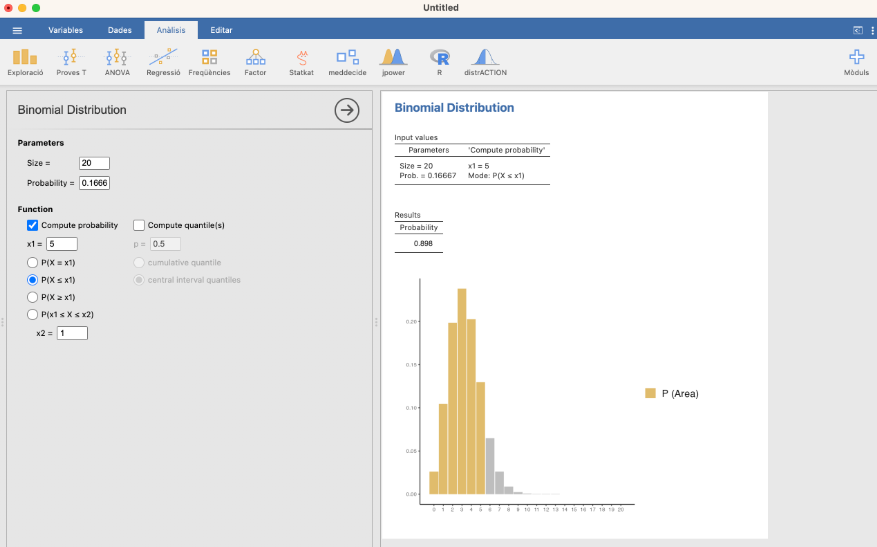

Con las notaciones anteriores, nos piden \(P(X\leqslant 5)\). Da 0.898:

Si lanzamos 20 veces un dado equilibrado, ¿cuál es la probabilidad de sacar menos de 5 unos?

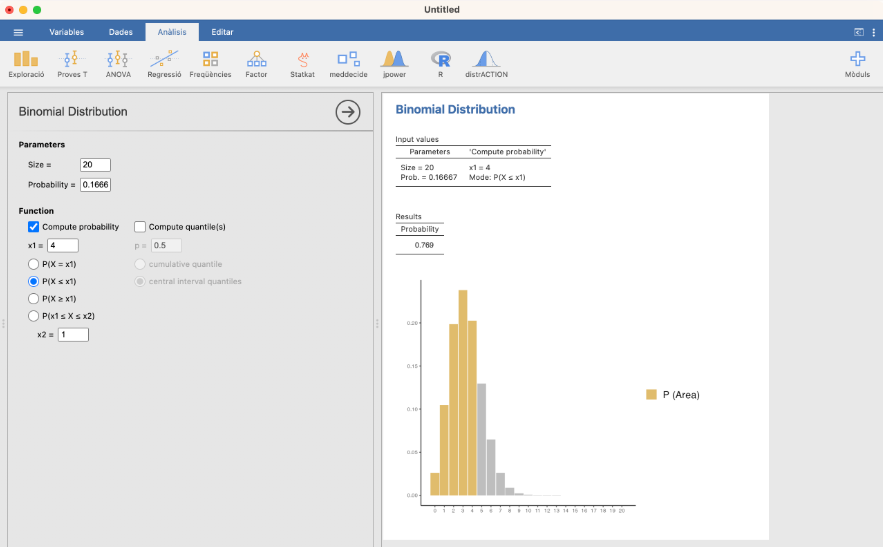

Con las notaciones anteriores, nos piden \(P(X< 5)\), es decir, \(P(X\leqslant 4)\). Da 0.769:

Si lanzamos 20 veces un dado equilibrado, ¿cuál es el menor número \(N\) de unos para el que la probabilidad de sacar como máximo \(N\) unos llega al 25%?

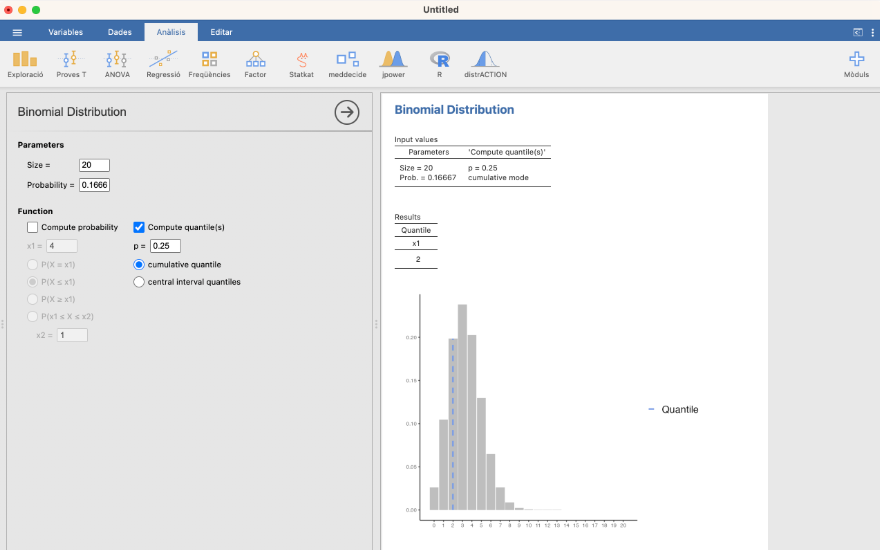

Nos piden el menor valor \(N\) tal que \(P(X\leqslant N)\geqslant 0.25\), y esto por definición es el 0.25-cuantil de \(X\). Da 2:

Podéis comprobar que en efecto \(N=2\) cumple lo pedido: si las calculáis, veréis que la probabilidad de sacar como máximo 2 unos es \(P(X\leqslant 2)=0.329\) y la probabilidad de sacar como máximo 1 uno es \(P(X\leqslant 1)=0.13\). Por lo tanto, con 1 uno no llegamos al 25% de probabilidad y con 2 sí.

5.2.2 Variables aleatorias hipergeométricas

Recordad que el paradigma de variable aleatoria binomial es: tengo una población con una proporción \(p\) de sujetos que satisfacen una condición \(E\), tomo una muestra aleatoria simple de tamaño \(n\) y cuento el número de sujetos \(E\) en mi muestra. Si cambiamos “muestra aleatoria simple” por “muestra aleatoria sin reposición”, la distribución de la variable aleatoria que obtenemos es otra: la hipergeométrica.

Una variable aleatoria hipergeométrica (o tiene distribución hipergeométrica) de parámetros \(K\), \(M\) y \(n\) (para abreviar, \(H(K,M,n)\)) es cualquier variable aleatoria \(X\) que podáis identificar con el proceso siguiente: Tenemos una población formada por \(K\) sujetos que satisfacen una condición \(E\) y \(M\) sujetos que no la satisfacen (por lo tanto, en total, \(K+M=N\) sujetos en la población), tomamos una muestra aleatoria sin reposición de tamaño \(n\) y contamos el número de sujetos \(E\) en esta muestra.

Llamaremos a \(K\) el número poblacional de éxitos, a \(M\) el número poblacional de fracasos y a \(n\) el tamaño de las muestras. Fijaos entonces que \(K+M=N\) es el tamaño total de la población y que \(K/(K+M)\) es la probabilidad poblacional de éxito (la fracción de sujetos que satisfacen \(E\) en el total de la población), que llamaremos \(p\).

Ejemplo:En una aula hay 5 chicos y 45 chicas. Escogemos 10 estudiantes, uno tras otro y sin repetirlos, para hacerles una pregunta. Contamos cuántos chicos hemos interrogado. Se trata de una variable hipergeométrica \(H(5,45,10)\).

Teorema: Si \(X\) es una variable \(H(K,M,n)\):

Su dominio es \(D_X=\{0,1,\ldots,\text{min}(N,n)\}\)

Su función de densidad es \[ f_X(k)=\left\{\begin{array}{ll} \displaystyle\dfrac{\binom{K}{k}\cdot \binom{M}{n-k}}{\binom{N}{n}} & \text{ si $k\in D_X$}\\ 0 & \text{ si $k\notin D_X$} \end{array}\right. \]

Su valor esperado es \(E(X)=\dfrac{nK}{N}\)

Su varianza es \(\sigma^2(X)=\dfrac{nKM(N-n)}{N^2(N-1)}\)

Fijaos en que si llamamos \(p\) a la probabilidad poblacional de éxito, \(p=K/N\), entonces \[ E(X)=np. \] Es la misma fórmula que para las variables binomiales \(B(n,p)\) (y si lo pensáis un rato veréis que, de nuevo y por el mismo argumento, es lo razonable). Por otro lado, \[ \sigma^2(X)=n\cdot\dfrac{K}{N}\cdot\dfrac{M}{N}\cdot\frac{N-n}{N-1}=np(1-p)\cdot\dfrac{\mathbf{N}-n}{\mathbf{N}-1} \] que es la varianza de una variable \(B(n,p)\) multiplicada por un factor de corrección debido a que ahora tomamos muestras sin repeticiones, lo que hace que la dispersión de resultados sea más pequeña que si permitiéramos repeticiones (yendo a un caso extremo, de tamaño \(N\) hay una sola muestra posible sin repetición, pero muchísimas si permitimos repeticiones). A la raíz cuadrada de este factor, \[ \sqrt{\dfrac{N-n}{N-1}} \] se la llama factor (corrector) de población finita.

Fijaos en que si \(N\) es muchísimo mayor que \(n\), tendremos que \(N-n \approx N-1\) y por lo tanto \((N-n)/(N-1)\approx 1\) y la varianza de la hipergeométrica será aproximadamente la de la binomial. Esto es consistente con lo que ya hemos comentado varias veces: si la población es mucho mayor que la muestra, tomar las muestras con o sin reposición no afecta demasiado a las muestra obtenidas, por lo que la distribución de probabilidad ha de ser muy parecida. Recordad los ejemplos siguientes:

En España hay 46,700,000 personas, de las cuales un 11.7% son diabéticos. Escogemos 100 españoles y contamos cuántos son diabéticos.

Esta variable es, en realidad, hipergeométrica con \(K=0.117\cdot 46700000=5463900\), \(M=46700000-N=41236100\) y \(n=100\), pero en la práctica la consideramos binomial \(B(100,0.117)\). El factor de población finita es \[ \frac{46700000-100}{46700000-1}=0.9999979 \]

Hay otro motivo para considerarla binomial en este ejemplo, y es que, en realidad, no sabemos los valores exactos de \(K\) y \(M\). Estamos seguros de que no es verdad que el tamaño de la población española sea exactamente de 46,700,000 personas, tan redondo, ni que los diabéticos representen exactamente un 11.7%, sin más cifras decimales. Así que ya puestos a aproximar, tomamos la aproximación binomial, que es más sencilla.

Pero cuidado: si la muestra fuera, pongamos, de 10,000 personas, entonces la aproximación binomial sería teóricamente incorrecta, aunque el factor corrector de población finita es de 0.999786: de media, un poco menos de 2 de cada 3 muestras aleatorias simples de 10,000 personas tomadas de una población de 46,700,000 personas contienes alguna repetición, como muestra el cálculo siguiente.

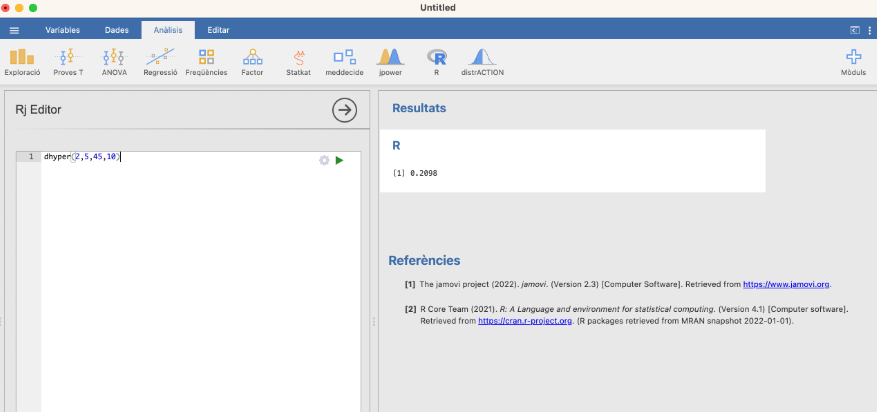

Para hacer cálculos de la hipergeométrica en Jamovi:

Ejemplo:En una clase de 50 estudiantes, 5 son hombres (y 45 mujeres). Escogemos una muestra aleatoria sin reposiciòn de 10 estudiantes. ¿Cuál es la probabilidad de que exactamente dos de los estudiantes elegidos sean hombres?

La variable \(X\) que cuenta el número de hombres en estas muestras es hipergeométrica \(H(5,45,10)\). Nos piden \(P(X=2)\), y esta probabilidad nos la da la función de densidad de \(X\). Es \(f_X(2)\):

dhyper(2,5,45,10)[1] 0.2098397

Fijaos en el orden de los argumentos de la función entre los paréntesis. Para calcular \(f_X(x)\), aplicamos dhyper a \((x,K,M,n)\).

En la situación anterior, ¿cuál es la probabilidad de la muestra contenga como máximo 2 hombres?, ¿cuál es la probabilidad de la muestra contenga al menos 2 hombres?

5.2.3 Variables aleatorias de Poisson

Una variable aleatoria \(X\) es de Poisson (o tiene distribución de Poisson) con parámetro \(\lambda>0\) (para abreviar, \(Po(\lambda)\)) cuando:

Su dominio es \(D_X=\mathbb{N}\), el conjunto de todos los números naturales (es decir, teóricamente puede tomar como valor cualquier número natural).

Su función de densidad es \[ f_X(k)=\left\{\begin{array}{ll} e^{-\lambda}\cdot \dfrac{\lambda^k}{k!} & \text{ si $k\in \mathbb{N}$}\\ 0 & \text{ si $k\notin \mathbb{N}$} \end{array}\right. \]

Teorema: Si \(X\) es una variable \(Po(\lambda)\), entonces \(E(X)= \sigma^2(X)= \lambda\).

Es decir, el “parámetro” \(\lambda\) de una variable de Poisson es su valor esperado, y coincide con su varianza.

La familia de Poisson incluye un tipo de variables aleatorias muy común en epidemiología.

Supongamos que tenemos un tipo de objetos o acontecimientos que pueden darse en una región continua de tiempo o espacio. Por ejemplo, defunciones de personas por una determinada enfermedad en el curso del tiempo, casos de un tipo de cáncer en diferentes zonas geográficas de un país, o bacterias en una superficie. Para simplificar el lenguaje, vamos a suponer que observamos apariciones de objetos en el tiempo.

Si las apariciones de estos objetos satisfacen las propiedades siguientes:

Las apariciones de los objetos son aleatorias: en cada instante, un objeto se da, o no, al azar, con una probabilidad fija y constante

Las apariciones de los objetos son independientes: que se dé un objeto en un instante concreto, no depende para nada de que se haya dado o no un objeto en otro instante

Las apariciones de los objetos no son simultáneas: es prácticamente imposible que dos objetos de estos se den en el mismo instante exacto, medido con precisión infinita

entonces, la variable \(X_t\) que toma un intervalo de tiempo de duración \(t\) y cuenta el número de objetos que se dan en él es de Poisson: \(Po(\lambda_t)\), con \(\lambda_t\) el número esperado de objetos en este intervalo de tiempo (es decir, el número medio de objetos en intervalos de tiempo de este tamaño).

Por ejemplo, cuando lo que cuentan ocurre al azar, son variables de Poisson:

El número de enfermos admitidos en urgencias en un día (o en 12 horas, o en una semana…)

El número de defunciones por una enfermedad concreta en un día (o en una semana, o en un año…)

El número de bacterias en un cuadrado de 1 cm de lado (o de 1 m de lado…)

Más en concreto, si \(X\) es una variable binomial \(B(n,p)\) con \(n\) MUY grande y \(p\) MUY pequeño, entonces \(X\) es aproximadamente \(Po(\lambda)\) con \(\lambda=p\cdot n\). Aquí \(n\) es, para entendernos, el número de instantes en un día, o el número de puntos del cuadrado de 1 cm de lado: MUY grande.

Para que os hagáis una idea, la instrucción siguiente calcula el máximo (max) de los valores absolutos (abs) de las diferencias entre la densidad de una \(B(10^6,10^{-5})\) y una \(Po(10)\): esta diferencia máxima es del orden de 0.0000006.

max(abs(dbinom(0:10^6,10^6,10^-5)-dpois(0:10^6,10)))[1] 6.255548e-07Podemos aplicar esta información de dos maneras:

Si sabemos que una variable es (aproximadamente) de Poisson, conocemos su densidad y por lo tanto podemos calcular lo que queramos para ella.

Si los datos que observamos tocarían seguir una distribución de Poisson pero parece que no (por ejemplo, porque su varianza sea muy diferente de su media, tan diferente que sea difícil de creer que la media y la varianza poblacionales sean iguales), entonces es señal de que algo “raro” está pasando en realidad.

Observad la diferencia entre las dos variables siguientes:

Número semanal de defunciones por un tipo de cáncer en un país. El momento exacto de las defunciones se produce al azar, podemos entender que no se dan dos defunciones exactamente en el mismo instante, con precisión infinita, y las defunciones se producen de manera independiente. Es de Poisson.

Número semanal de defunciones en accidentes de tráfico en un país. De nuevo, el momento exacto de las defunciones se produce al azar y podemos entender que no se dan dos defunciones exactamente en el mismo instante, con precisión infinita. Pero las muertes en accidentes de tráfico no son independientes: en un mismo accidente mortal se pueden producir varias muertes casi simultáneas. No es buena idea modelarla mediante una distribución de Poisson. En cambio, el número de accidentes de tráfico sí.

Como las apariciones de los objetos que cuenta una variable de Poisson son aleatorias e independientes, el número medio de objetos es lineal en el tamaño de la región. Es decir, por ejemplo, en un intervalo de dos días esperamos ver el doble de objetos que en un día. O por ejemplo, si se diagnostican de media 32,240 casos de cáncer de colon anuales en España (y siguen una ley de Poisson), esperamos que de media se diagnostiquen 32240/52=620 casos semanales.

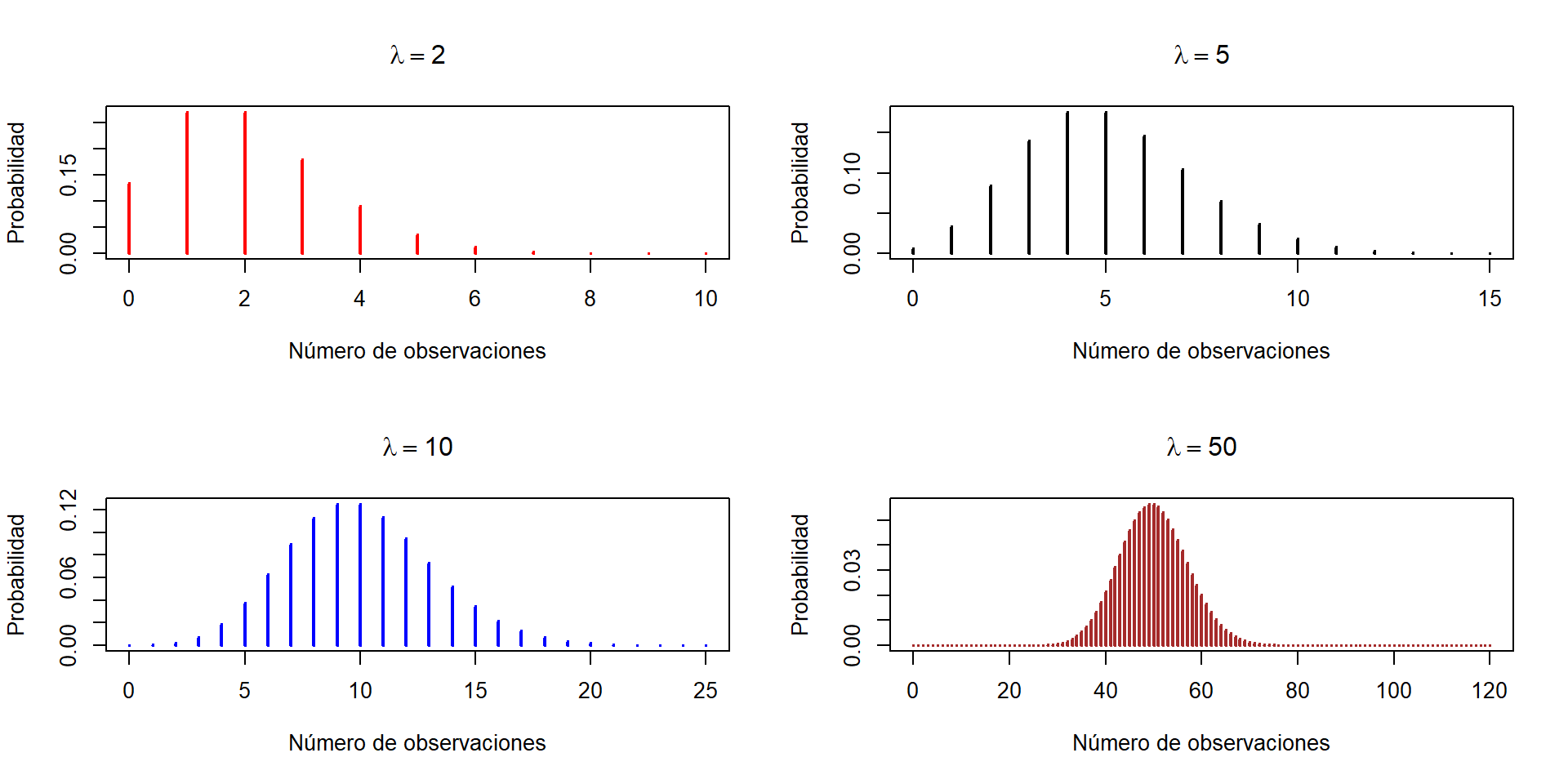

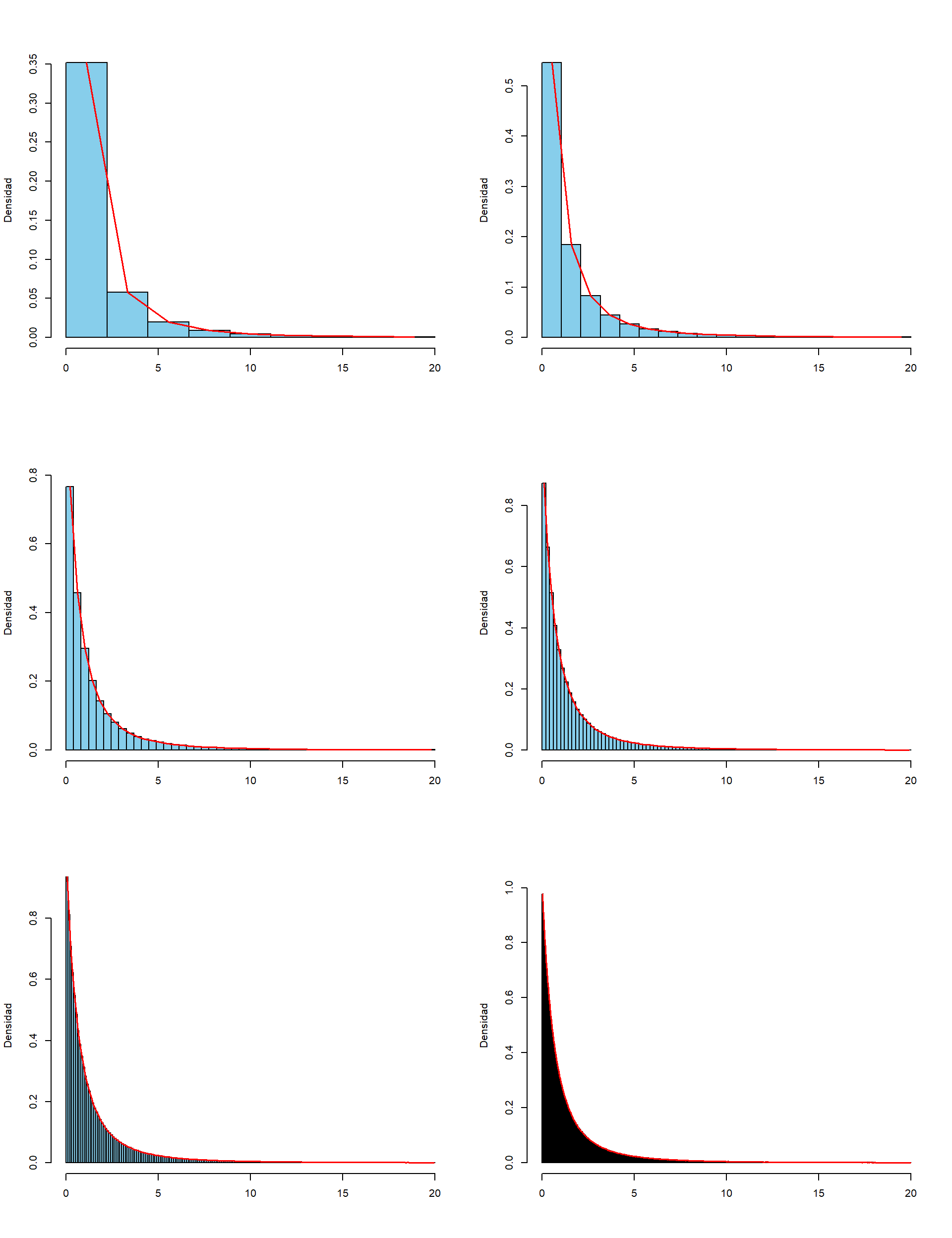

Veamos algunos gráficos de funciones de densidad de variables de Poisson.

Como podéis ver, la densidad de una variable de Poisson es asimétrica, con un máximo alrededor de \(\lambda\) y una cola a la derecha, pero a medida que \(\lambda\) crece, la asimetría se va atenuando.

Ejemplo:La incidencia anual de un cierto accidente laboral sigue una distribución de Poisson. A lo largo del tiempo se ha observado que el 55% de los años no se produce ningún accidente. ¿Cuántos accidentes esperas que ocurran en un año?

Sea \(X\) la variable que cuenta estos accidentes laborales anuales. Nos dicen que es \(Po(\lambda)\), donde \(\lambda\) es su valor esperado, y por lo tanto lo que nos piden. Nos dicen también que \(P(X=0)=0.55\). Por la fórmula de la densidad de una variable de Poisson: \[ 0.55=e^{-\lambda}\cdot \dfrac{\lambda^0}{0!}=e^{-\lambda}\Longrightarrow \lambda=-\ln(0.55) \]

5.3 Variables aleatorias continuas

Recordad que una variable aleatoria continua toma valores continuos. Por ejemplo:

- Peso de una persona

- Nivel de colesterol en sangre

- Diámetro de un tumor

En este curso vamos a restringirnos a variables aleatorias continuas \(X: \Omega\to \mathbb{R}\) que cumplen la siguiente propiedad extra: su función de distribución \[ \begin{array}{rcl} F_X: \mathbb{R} & \to & [0,1]\\ x &\mapsto &P(X\leqslant x) \end{array} \] es continua. Todas las variables aleatorias continuas que os puedan interesar en algún momento van a tener esta propiedad, así que no perdemos nada imponiéndola. ¿Y qué ganamos? Pues que podemos usar todas las técnicas matemáticas aplicables a funciones continuas para estudiar \(F_X\).

Por ejemplo, nuestras variables continuas verifican la propiedad siguientes:

Teorema: Si \(X\) es una variable aleatoria continua, la probabilidad de que tome un valor concreto siempre es 0: \[ P(X=a)=0 \text{ para todo $a\in \mathbb{R}$}. \]

Por si pasa por aquí alguien que necesite una demostración: \[ \begin{array}{l} \displaystyle P(X=a) = P(X\leqslant a)-P(X<a)=P(X\leqslant a)-P\Big(\bigcup_{n\geqslant 1} \Big(X\leqslant a-\frac{1}{n}\Big)\Big)\\ \displaystyle \qquad= P(X\leqslant a)-\lim_{n\geqslant 1}P\Big(X\leqslant a-\frac{1}{n}\Big)\\ \displaystyle \qquad= F_X(a)-\lim_{n\geqslant 1}F_X\Big(a-\frac{1}{n}\Big)=0 \end{array} \] porque \(F_X\) es continua.

En particular, para una variable aleatoria continua:

Probabilidad 0 no significa imposible.

Cada valor de \(X\) tiene probabilidad 0, pero cuando tomamos un sujeto, tendrá algún valor de \(X\), ¿no?. Por lo tanto, su valor de \(X\) es posible, aunque tenga probabilidad 0.

De \(P(X=a)=0\) se deduce que la probabilidad de un suceso definido con una desigualdad es la misma que la del suceso correspondiente definido con una desigualdad estricta. Por ejemplo, y contrariamente a lo que pasaba en las variables aleatorias discretas, para una variable aleatoria continua siempre tenemos que \[ P(X\leqslant a)=P(X<a) \] porque \[ P(X\leqslant a)=P(X<a)+P(X=a)=P(X<a)+0=P(X<a). \]

De manera similar:

- \(P(X\geqslant a)=P(X> a)+P(X=a)=P(X> a)\)

- \(P(a\leqslant X\leqslant b)=P(a<X<b)+P(X=a)+P(X=b)\) \(=P(a<X<b)\)

5.4 Densidad y distribución

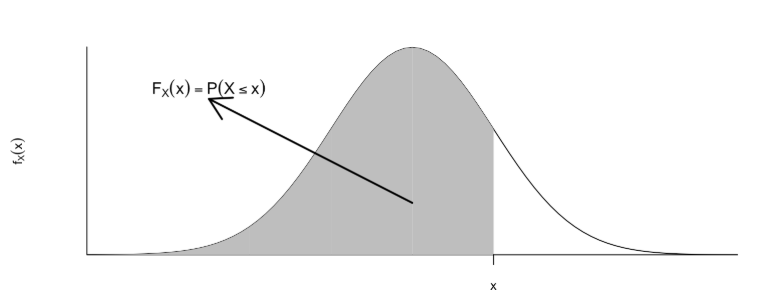

Sea \(X\) una variable aleatoria continua. Como ya hemos dicho, su función de distribución \(F_X\) se sigue definiendo como \[ x\mapsto F_X(x)=P(X\leqslant x) \] recordando además que, ahora, también \[ F_X(x)=P(X< x) \]

Pero puesto que tenemos que \(P(X=x)=0\), ahora no podemos definir la función de densidad de \(X\) como \(f_X(x)=P(X=x)\). ¿Qué podemos hacer?

Recordad que, en las variables aleatorias discretas \[ F_X(a)=\sum_{x\leqslant a} f_X(x) \]

En el contexto de matemáticas “continuas”, la suma \(\sum\) se traduce en la integral \(\int\). Se define entonces la función de densidad de una variable aleatoria continua \(X\) como la función \(f_X:\mathbb{R}\to \mathbb{R}\) tal que:

\(f_X(x)\geqslant 0\), para todo \(x\in \mathbb{R}\)

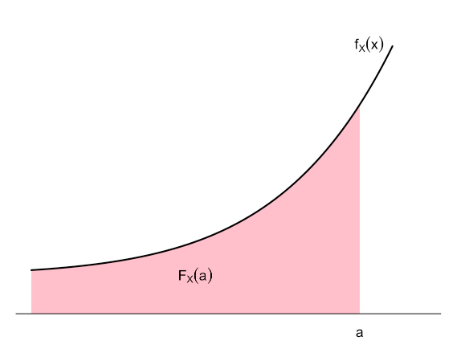

\(\displaystyle F_X(a)=\int_{-\infty}^a f_{X}(x)\, dx\) para todo \(a\in \mathbb{R}\).

Recordad (o aprended por primera vez) que la integral tiene una interpretación sencilla en términos de áreas. En concreto, dados \(a\in \mathbb{R}\) y una función \(f(x)\), la integral \[ \int_{-\infty}^a f(x)\, dx \] es igual al área de la región a la izquierda de la recta vertical \(x=a\) comprendida entre la curva \(y=f(x)\) y el eje de abscisas \(y=0\). Por lo tanto, la función de densidad \(f_X\) de \(X\) es la función positiva tal que para todo \(a\in \mathbb{R}\), \(F_X(a)\) es igual al área bajo la curva \(y=f_X(x)\) (entre esta curva y el eje de abscisas) a la izquierda de \(x=a\).

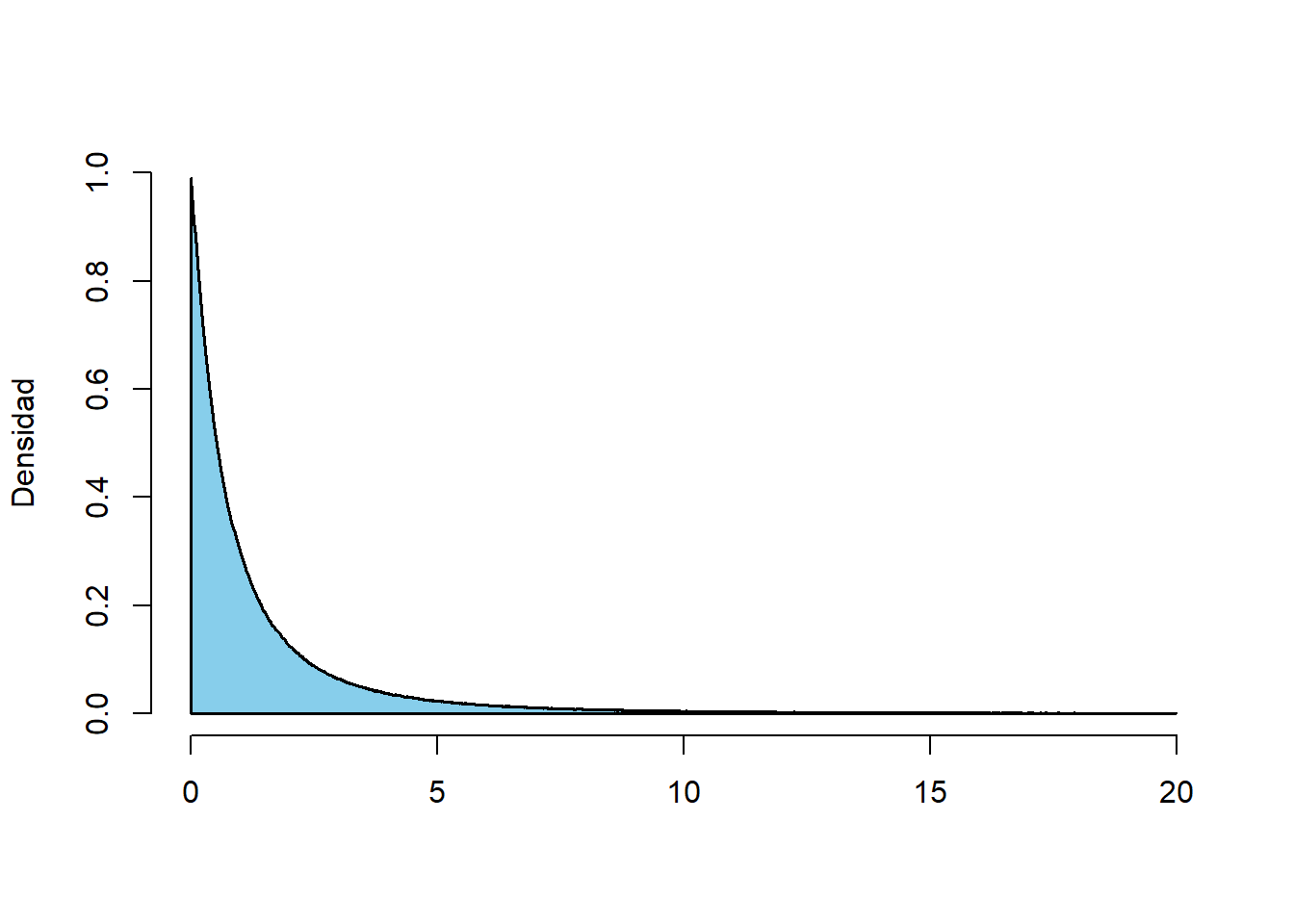

¿Cuál es la idea intuitiva que hay detrás de esta definición de densidad? Suponed que dibujamos histogramas de frecuencias relativas de los valores de \(X\) sobre toda la población. Como estamos hablando de toda la población, la frecuencia relativa de cada clase es la proporción de individuos de la población cuyo valor de \(X\) pertenece a esta clase: es decir, la probabilidad de que \(X\) caiga dentro de la clase.

Recordad que, en un histograma de frecuencias relativas:

- La frecuencia relativa (ahora, la probabilidad) de cada clase es el área de su barra, es decir, el ancho de la clase por la altura de la barra.

- Llamamos a la altura de una barra la densidad de la clase.

- Si \(a\) es un extremo de una clase, la frecuencia relativa acumulada (la probabilidad) de que \(X<a\) es la suma de las áreas de las barras a la izquierda de \(a\).

Si dibujamos los histogramas de \(X\) tomando clases cada vez más estrechas, sus polígonos de frecuencias (en rojo) tienden a dibujar una curva:

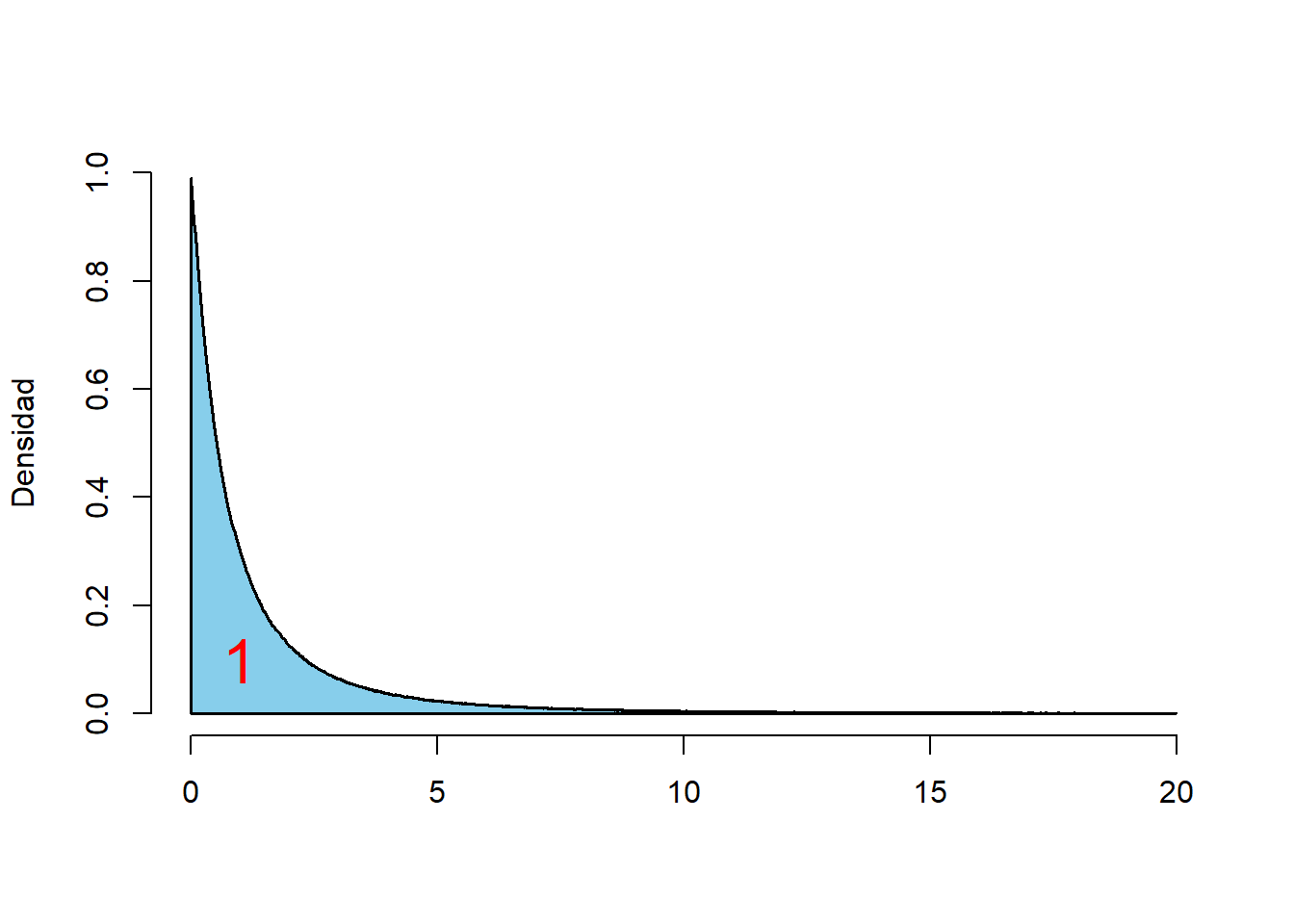

Cuando el ancho de las clases tiende a 0, obtenemos una curva que es el límite de estos polígonos de frecuencias:

En el límite, la probabilidad de que \(X< a\) (o sea, de que \(X\leqslant a\)) será el límite de las sumas de las áreas de las barras a la izquierda de \(a\), y por tanto el área a la izquierda de \(a\) bajo esta curva límite. Esto nos dice que esta curva es precisamente la función de densidad \(y=f_X(x)\).

La función de densidad \(f_X\) de una variable aleatoria continua \(X\) es la función límite de los polígonos de frecuencias de histogramas de \(X\) cuando el ancho de las clases tiende a 0.

Veamos algunas propiedades que se deducen de que \(F_X(a)=P(X\leqslant a)\) sea igual al área bajo la curva \(y=f_X(x)\) a la izquierda de \(x=a\):

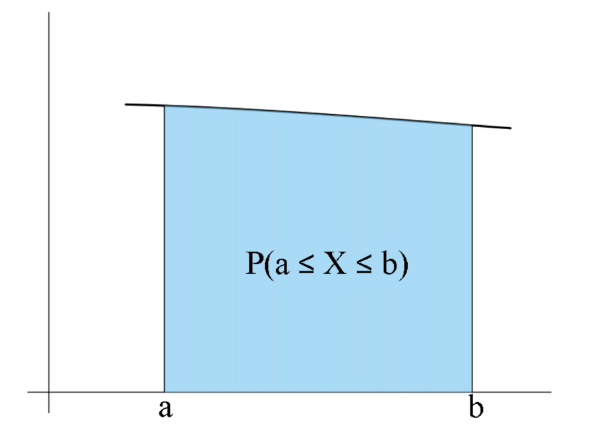

- Como \(P(X<\infty)=P(\Omega)=1\), el área total bajo la curva \(y=f_X(x)\) es 1.

- \(P(a\leqslant X\leqslant b)=P(X\leqslant b)-P(X<a)\) es el área bajo la curva \(y=f_X(x)\) a la izquierda de \(x=b\) menos el área bajo la curva \(y=f_X(x)\) a la izquierda de \(x=a\), es decir, \(P(a\leqslant X\leqslant b)\) es igual al área bajo la curva \(y=f_X(x)\) entre \(x=a\) y \(x=b\).

- Si \(\varepsilon>0\) es muy, muy pequeño, el área bajo \(y=f_X(x)\) entre \(a-\varepsilon\) y \(a+\varepsilon\) es aproximadamente igual a la del rectángulo de base el intervalo \([a-\varepsilon,a+\varepsilon]\) y altura \(f_X(a)\), que vale \(2\varepsilon\cdot f_X(a)\) (ved la Figura @ref(fig:epsilon)). Es decir, \[ P(a-\varepsilon\leqslant X\leqslant a+\varepsilon)\approx 2\varepsilon\cdot f_X(a). \]

Por lo tanto \(f_X(a)\) nos da una indicación de la probabilidad de que \(X\) valga aproximadamente \(a\) (pero no es \(P(X=a)\), que vale 0). Es decir, por ejemplo, si \(f_X(a)=0.1\) y \(f_X(b)=0.5\), la probabilidad de que \(X\) tome un valor muy cercano a \(b\) es 5 veces mayor que la probabilidad de que tome un valor muy cercano a \(a\).

Pero \(P(X=a)=P(X=b)=0\), así que, por favor, evitad decir que “la probabilidad de que \(X\) valga \(b\) es 5 veces mayor que la probabilidad de que valga \(a\)”. Sí, ya sabemos que \(5\cdot 0=0\), pero la frase es engañosa.

Unas consideraciones finales:

Lo hemos dicho en la definición, y lo hemos usado implícitamente en toda la sección, pero lo volvemos a repetir: \(f_X(x)\geqslant 0\) para todo \(x\in \mathbb{R}\).

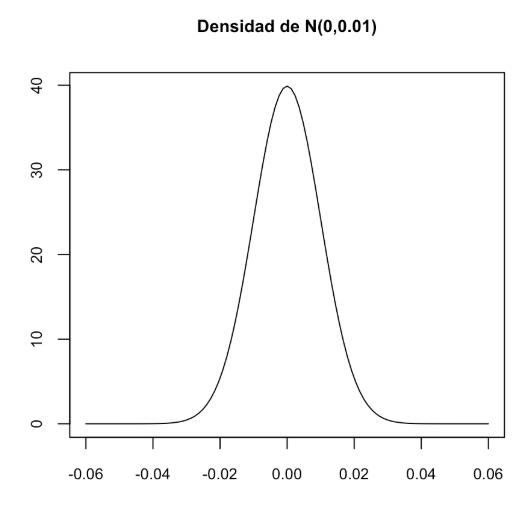

\(f_X(x)\) no es una probabilidad, y por lo tanto puede ser mayor que 1. Por ejemplo, el gráfico siguiente muestra la densidad de una variable normal \(N(0,0.01)\), que llega a valer casi 40. Pero el área bajo toda la curva densidad es 1: a partir de \(\pm 0.06\) la densidad vale prácticamente 0.

- La función de densidad \(f_X\) no tiene por qué ser continua, aunque la función de distribución \(F_X\) lo sea.

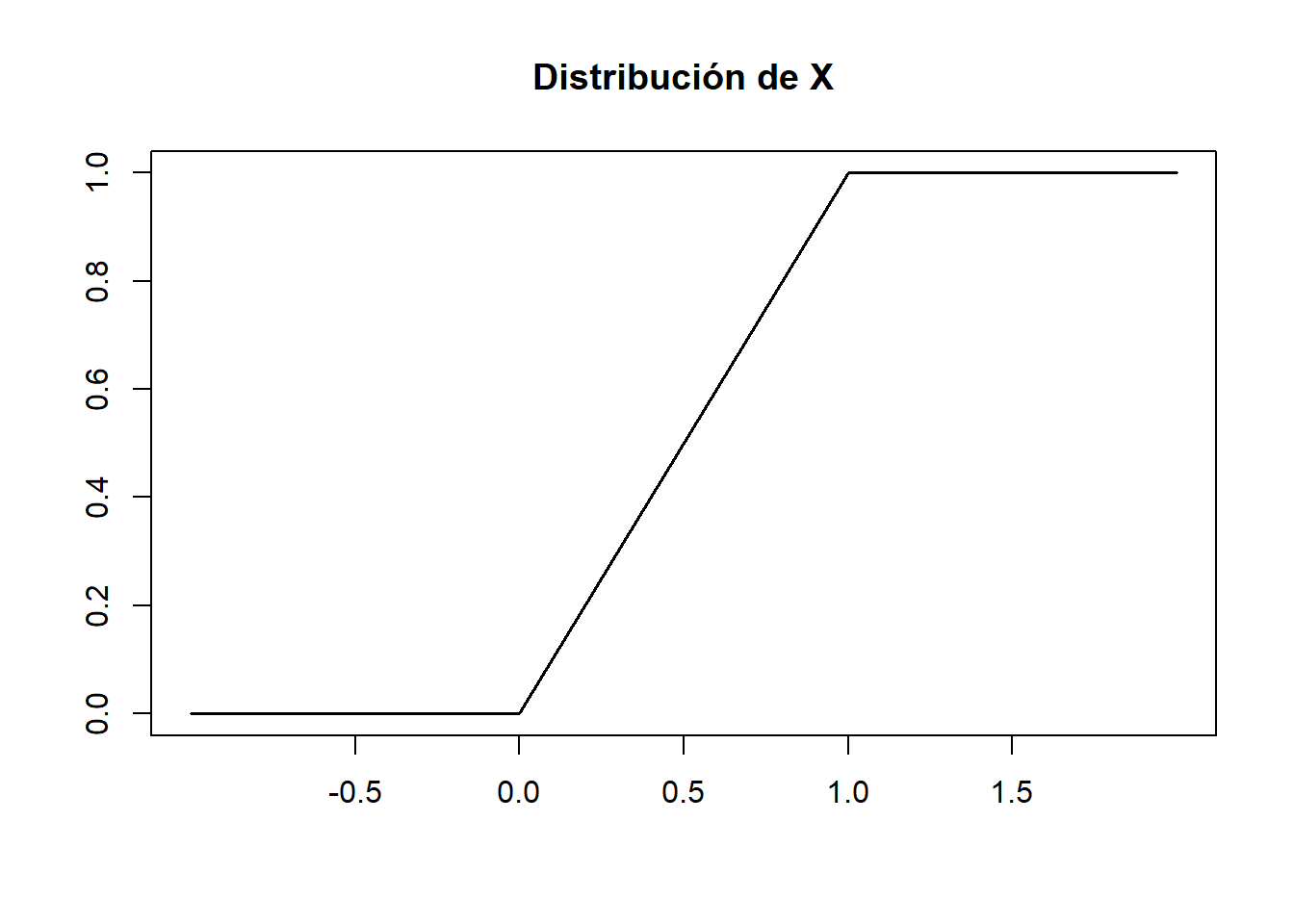

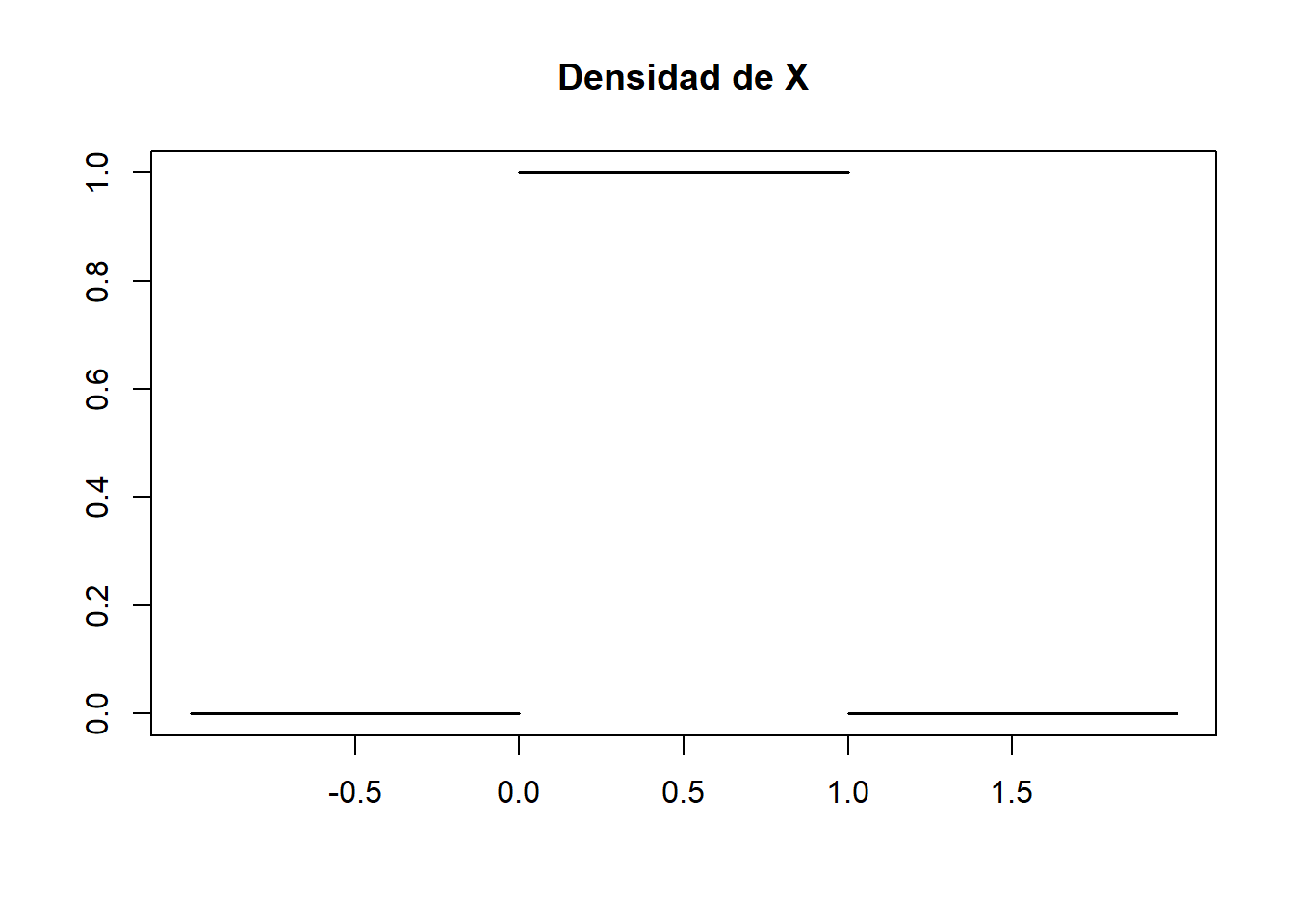

Sea \(X\) una variable aleatoria continua con función de distribución \[ F_X(x)=P(X\leqslant x)=\left\{ \begin{array}{ll} 0 & \text{ si $x\leqslant 0$}\\ x & \text{ si $x\in [0,1]$}\\ 1 & \text{ si $x\geqslant 1$} \end{array}\right. \]

Su función de densidad es \[ f_X(x)\left\{ \begin{array}{ll} 0 & \text{ si $x< 0$}\\ 1 & \text{ si $x\in [0,1]$}\\ 0 & \text{ si $x> 1$} \end{array}\right. \] porque la integral de \(-\infty\) hasta \(a\) de esta función es (calculadlo como áreas si os cuesta recordar cómo calcular integrales definidas) \[ \int_{-\infty}^a f_X(x)\,dx=\left\{ \begin{array}{ll} \int_{-\infty}^a 0\,dx =0 & \text{ si $a< 0$}\\ \int_{-\infty}^0 0\,dx+ \int_{0}^a 1\,dx=0 + a=a & \text{ si $a\in [0,1]$}\\ \int_{-\infty}^0 0\,dx+ \int_{0}^1 1\,dx+ \int_{1}^a 0\,dx=0 + 1+0=1 & \text{ si $x> 1$} \end{array}\right. \]

Observad que \(f_X(x)\) es discontinua, con saltos en 0 y 1. Esta densidad representa que \(X\) solo puede tomar valores entre 0 y 1 y que entre estos dos valores los toma todos “con la misma probabilidad”. Diremos que \(X\) tiene distribución uniforme entre 0 y 1.

Ejercicio: Más en general, una variable con distribución uniforme entre \(a\) y \(b\) (con \(a<b\)) solo puede tomar valores entre \(a\) y \(b\) y entre estos dos valores los toma todos “con la misma probabilidad”. ¿Cuál sería su densidad? ¿Cuál sería su distribución? Comprobad que el área bajo la curva de la densidad que hayáis dado es la distribución que hayáis dado.

5.4.1 Esperanza, varianza, cuantiles…

La esperanza y la varianza de una variable aleatoria continua \(X\), con función de densidad \(f_X\), se definen como en el caso discreto, substituyendo la suma \(\sum_{x\in D_x}\) por una integral \(\int_{-\infty}^{\infty}\).

La media, o esperanza (valor medio, valor esperado…), de \(X\) es \[ E(X)=\int_{-\infty}^{\infty}x \cdot f_{X}(x)\, dx \] Es decir, es el área comprendida entre el eje de abscisas y la curva \(y=xf_X(x)\). Como en el caso discreto, también la denotaremos a veces por \(\mu_X\).

Este valor tiene la misma interpretación que en el caso discreto:

Representa el valor medio de \(X\) sobre el total de la población.

Es (con probabilidad 1) el límite de la media aritmética de los valores de \(X\) sobre muestras aleatorias simples de tamaño \(n\), cuando \(n\to \infty\).

Volvamos a la variable aleatoria \(X\) con distribución uniforme entre 0 y 1 del Ejemplo @ref(exm:unif), que toma todos los valores entre 0 y 1 con la misma probabilidad. ¿Cuál tendría que ser su valor medio? El valor medio del intervalo, 1/2, ¿no?. Veamos: como \(f_X(x)=1\) entre 0 y 1 y \(f_X(x)=0\) fuera de este intervalo, \[ \int_{-\infty}^{\infty}x \cdot f_{X}(x)\, dx =\int_{0}^1 x\,dx=\left[\frac{x^2}{2}\right]^1_0=\frac{1}{2}-0=\frac{1}{2} \] Nuestra intuición era correcta.

Si \(g:\mathbb{R}\to \mathbb{R}\) es una función continua, la esperanza de la composición \(\Omega \stackrel{X}{\longrightarrow} \mathbb{R}\stackrel{g}{\longrightarrow}\mathbb{R}\) es \[ E(g(X))=\int_{-\infty}^{+\infty} g(x) \cdot f_X(x)dx \]

La varianza de \(X\) es \[ \sigma^2(X)=E((X-\mu_X)^2) \] y se puede demostrar que es igual a \[ \sigma^2(X)=E(X^2)-\mu_X^2 \] También se escribe \(\sigma_X^2\).

La desviación típica de \(X\) es \[ \sigma(X)=+\sqrt{\sigma^2(X)} \] y también se escribe \(\sigma_X\).

Como en el caso discreto, la varianza y la desviación típica miden la variabilidad de los resultados de \(X\) respecto de su valor medio.

Estos parámetros de \(X\) tienen las mismas propiedades en el caso continuo que en el discreto. Las recordamos:

Si \(b\) es una variable aleatoria constante, \(E(b)=b\) y \(\sigma(b)^2=0\).

Si \(\sigma^2X)=0\), \(X\) es constante.

Y por supuesto, si \(X\) solo puede tomar un valor, ya no es continua, sino discreta. Por lo tanto, por convenio, de ahora en adelante supondremos que nuestras variables aleatorias continuas siempre tienen varianza no nula.

Si \(X_1,\ldots,X_n\) son variables aleatorias y \(a_1,\ldots,a_n,b\in \mathbb{R}\), \[ E(a_1X_1+\cdots+a_nX_n+b)=a_1E(X_1)+\cdots+a_nE(X_n)+b \] En particular:

\(E(a X+b)=a E(X)+b\).

\(E(X+Y)=E(X)+E(Y)\).

Si \(X\leqslant Y\), entonces \(E(X)\leqslant E(Y)\).

Si \(a,b\in \mathbb{R}\), \(\sigma(aX+b)^2=a^2 \sigma^2(X)\) y \(\sigma(aX+b)=|a|\cdot \sigma(X)\).

Si \(X,Y\) son independientes, \(\sigma^2(X+Y)=\sigma^2(X)+\sigma^2(Y)\). Si no, en principio no.

Si \(X_1,\ldots,X_n\) son variables aleatorias independientes y \(a_1,\ldots,a_n,b\in \mathbb{R}\), \[ \begin{array}{l} \sigma^2(a_1X_1+\cdots+a_nX_n+b)=a_1^2\cdot\sigma^2(X_1)+\cdots+a_n^2\cdot\sigma^2(X_n)\\ \sigma(a_1X_1+\cdots+a_nX_n+b)=\sqrt{a_1^2\cdot\sigma^2(X_1)+\cdots+a_n^2\cdot\sigma^2(X_n)} \end{array} \] Si no son independientes, estas igualdades pueden ser falsas.

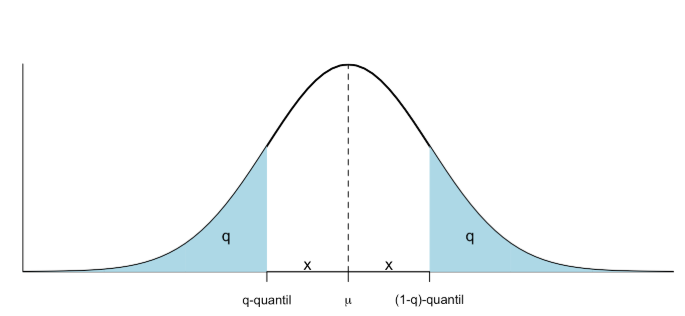

Dado \(p\) entre 0 y 1, el cuantil de orden \(p\) (o \(p\)-cuantil) de una variable aleatoria continua \(X\) es el menor valor \(x_p\in \mathbb{R}\) tal que \[ F_X(x_p)=P(X\leqslant x_p)=p \]

La mediana de \(X\) es su 0.5-cuantil, los primer y tercer cuartiles son su 0.25-cuantil y su 0.75-cuantil, etc.

Los coeficientes de asimetría y de curtosis se definen de manera similar a los de una muestra: \[ \begin{array}{l} \displaystyle \gamma_1=E\Big(\Big(\frac{X-\mu_X}{\sigma}\Big)^3\Big)\\ \displaystyle \beta_2=E\Big(\Big(\frac{X-\mu_X}{\sigma}\Big)^4\Big)-3 \end{array} \] Miden para la densidad de la variable lo que medían los de la muestra: el coeficiente de asimetría, si es simétrica o si tiene cola a algún lado; el coeficiente de curtosis, si sus colas son más largas o más cortas que las de una campana de Gauss.

5.4.2 Variables aleatorias normales

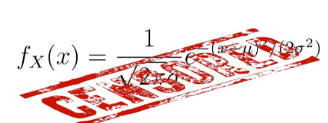

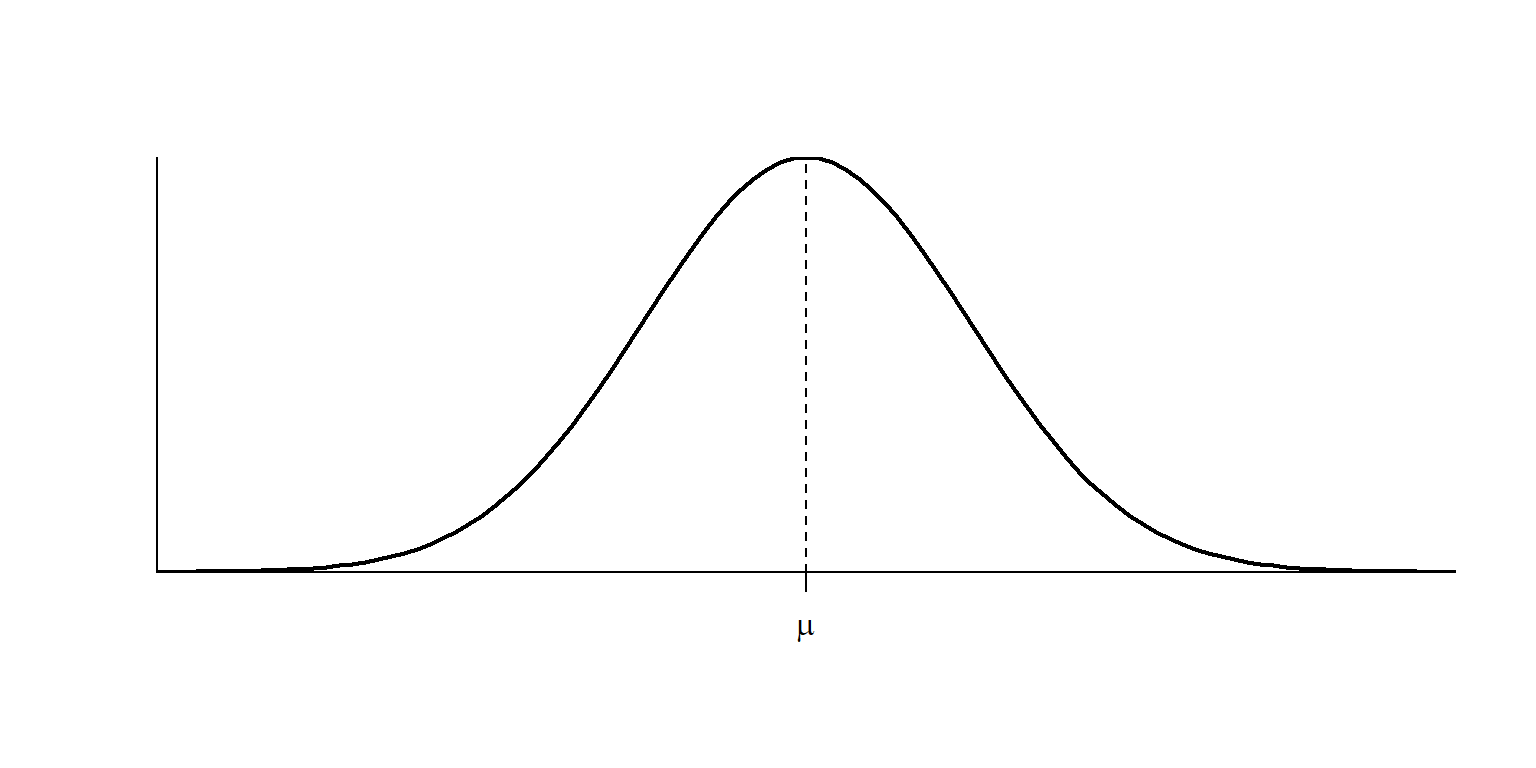

Una variable aleatoria continua \(X\) es normal (o tiene distribución normal) de parámetros \(\mu\) y \(\sigma\) (es \(N(\mu,\sigma)\), para abreviar) cuando su función de densidad es \[ f_{X}(x)=\frac{1}{\sqrt{2\pi}\sigma} e^{{-(x-\mu)^2}/{2\sigma^{2}}} \mbox{ para todo } x\in \mathbb{R} \]

Naturalmente, no os tenéis que saber esta fórmula.

Pero sí que tenéis que saber que:

Una variable aleatoria normal \(X\) es continua, y por lo tanto \(P(X=x)=0\), \(P(X\leqslant x)=P(X<x)\) etc.

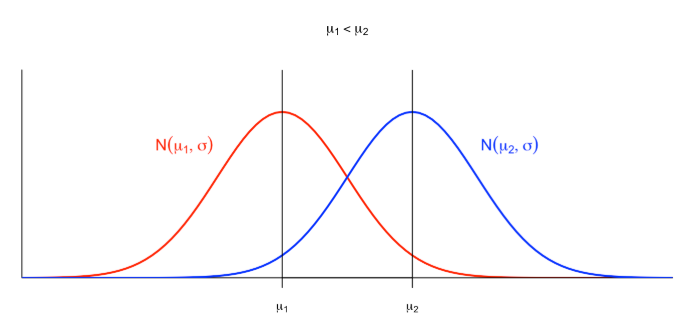

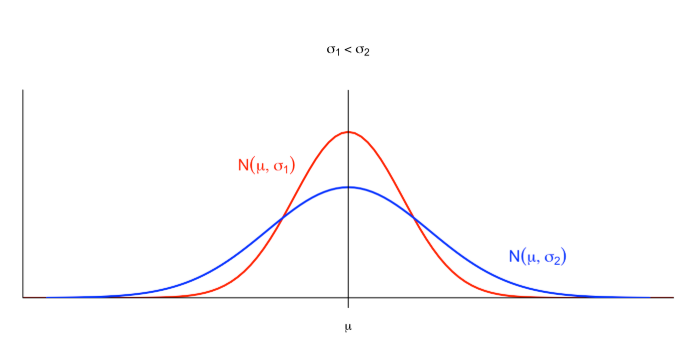

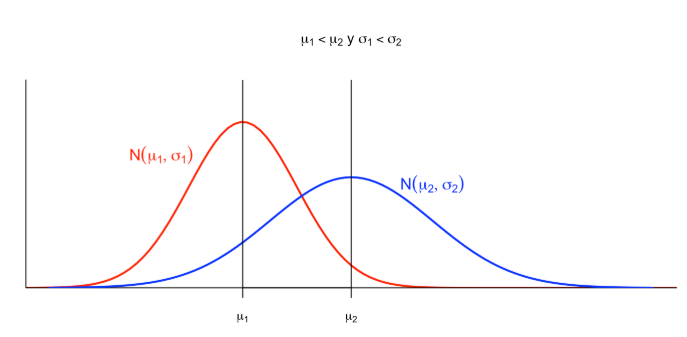

Si \(X\) es normal \(N(\mu,\sigma)\), su valor esperado es \(E(X)=\mu\) y su desviación típica es \(\sigma_X=\sigma\).

Si \(X\) es normal, su función de distribución \(F_X\) es inyectiva y creciente: si \(x<y\), \(F_X(x)<F_X(y)\).

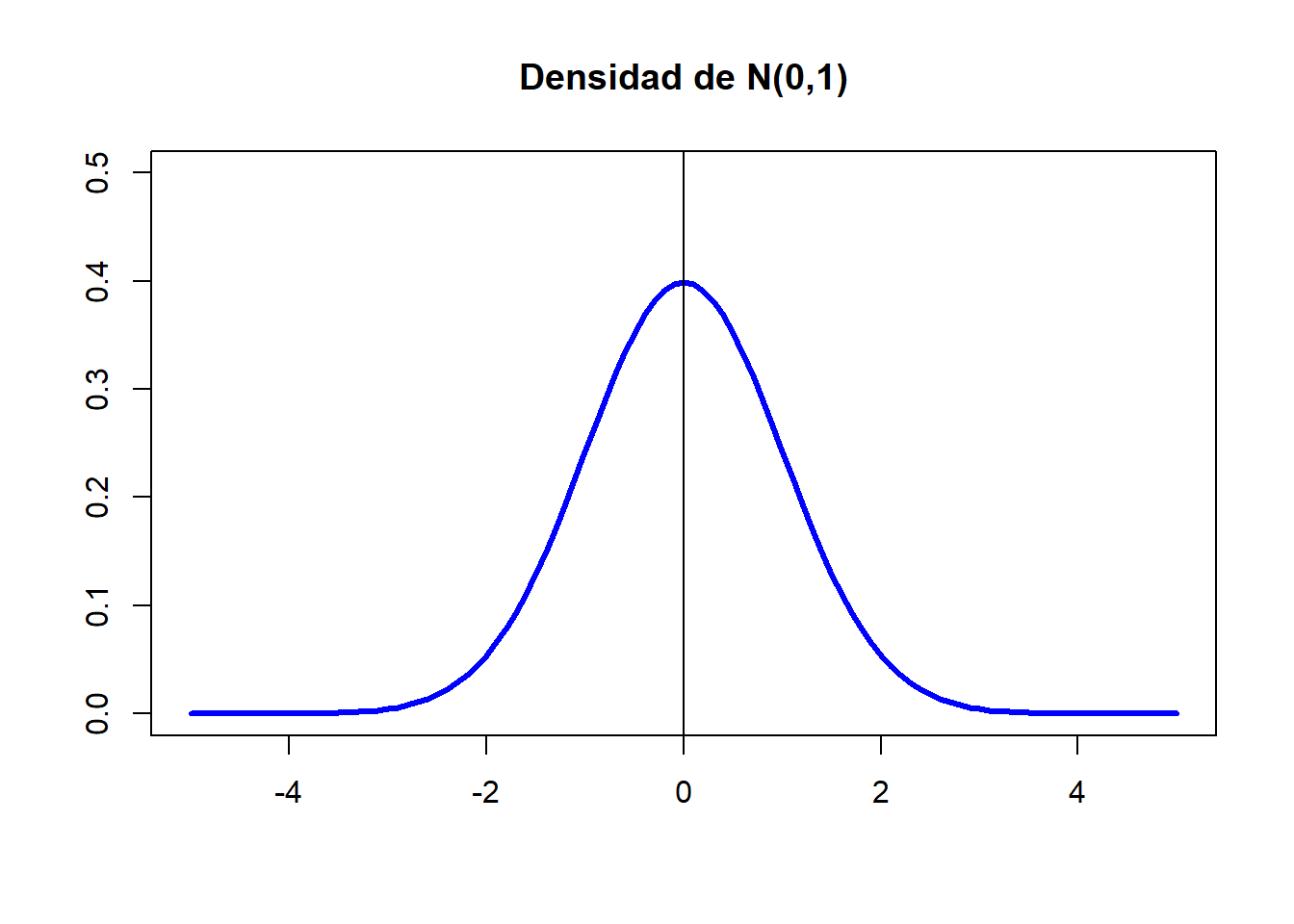

Una variable aleatoria normal es típica (o estándar) cuando es \(N(0,1)\). Usaremos normalmente \(Z\) para denotar una variable normal estándar. Por lo tanto, si \(Z\) es una normal estándar, \(E(Z)=0\) y \(\sigma(Z)=1\).

La gráfica de la densidad de una variable aleatoria normal es la famosa campana de Gauss de la que ya hemos hablado varias veces:

La distribución normal es una distribución teórica, no la encontraréis exacta en la vida real. Y pese a su nombre, no es más “normal” que otras distribuciones continuas.

Pero es muy importante, debido a que muchas distribuciones de la vida real son aproximadamente normales porque:

Ejemplo:Toda variable aleatoria que consista en tomar \(n\) medidas independientes de una o varias variables aleatorias y sumarlas, tiene distribución aproximadamente normal cuando \(n\) es muy grande, aunque las variables aleatorias de partida no sean normales.

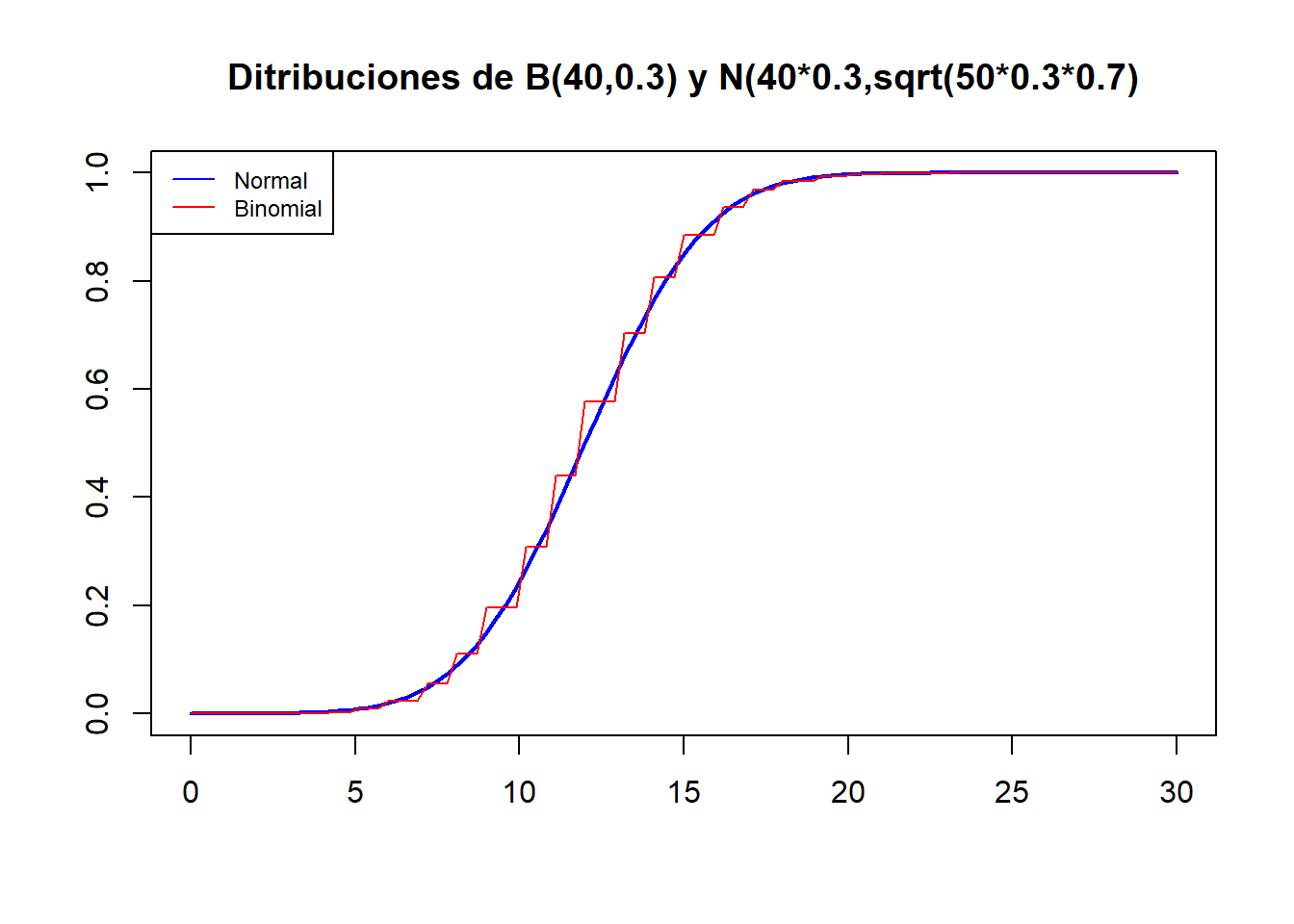

Una variable binomial \(B(n,p)\) se obtiene tomando \(n\) medidas independientes de una variable Bernoulli \(Be(p)\) y sumando los resultados. Por lo tanto, por la “regla” anterior, una \(B(n,p)\) tendría que ser aproximadamente normal si \(n\) es grande. Pues sí, si \(n\) es grande (pongamos mayor que 40, aunque si \(p\) está muy cerca de 0 o 1 el tamaño de las muestras tiene que ser mayor), la distribución de una variable \(X\) binomial \(B(n,p)\) se acerca mucho a la de una normal \(N(np,\sqrt{np(1-p)})\), donde, recordad que si \(X\) es \(B(n,p)\), entonces \(\mu_X=np\) y \(\sigma_X=\sqrt{np(1-p)}\).

Por ejemplo, el gráfico siguiente compara las funciones de distribución de una binomial \(B(40,0.3)\) y una normal \(N(40\cdot 0.3,\sqrt{40\cdot 0.3\cdot 0.7})\).

En los próximos temas utilizaremos a menudo que una variable \(B(n,p)\) con \(n\) es grande es aproximadamente \(N(np,\sqrt{np(1-p)})\).

Para calcular probabilidades de una \(N(\mu,\sigma)\), podéis usar JAMOVI o alguna aplicación para móvil o tablet.

Así, por ejemplo, si \(X\) es \(N(1,2)\)

- El 0.4-cuantil de \(X\), es decir, el valor \(q\) tal que \(P(X\leqslant q)=0.4\) es

- \(P(X=1.5)\) es

¡No! Como \(X\) es continua, \(P(X=1.5)=0\). Lo que os da dnorm(1.5,1,2) es el valor de la función de densidad de \(X\) en 1.5.

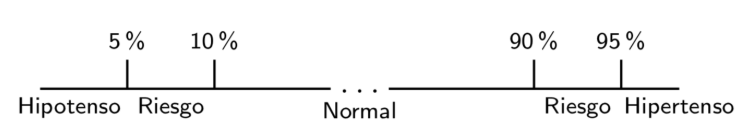

La presión sistólica, medida en mm Hg, es una variable aleatoria aproximadamente normal con valor medio \(\mu\) y desviación típica \(\sigma\) que dependen del sexo y la edad. Para la franja de edad 16-24 años, estos valores son:

- Para hombres, \(\mu=124\) y \(\sigma=13.7\)

- Para mujeres, \(\mu=117\) y \(\sigma=13.7\)

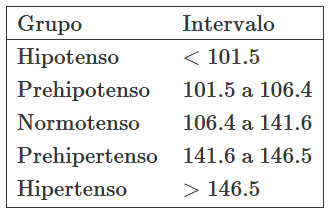

El modelo de hipertensión-hipotensión aceptado es el descrito en la Figura anterior. Queremos calcular los límites de cada clase para cada sexo en este grupo de edad.

Veamos:

- El límite superior del grupo de hipotensión será el valor que deja a la izquierda un 5% de las tensiones: el 0.05-cuantil de la distribución.

- El límite superior del grupo de riesgo de hipotensión será el valor que deja a la izquierda un 10% de las tensiones: el 0.1-cuantil de la distribución.

- El límite inferior del grupo de riesgo de hipertensión será el valor que deja a la izquierda un 90% de las tensiones: el 0.9-cuantil de la distribución.

- El límite inferior del grupo de hipertensión será el valor que deja a la izquierda un 95% de las tensiones: el 0.95-cuantil de la distribución.

En los hombres, la tensión sistólica es una variable aleatoria \(N(124,13.7)\). Si calculamos estos cuantiles, dan:

El 0.05-cuantil es 101.5

El 0.1-cuantil es 106.4

El 0.9-cuantil es 141.6

El 0.95-cuantil es 146.5

Ejercicio: Calculad estos límites para las mujeres de 16 a 24 años.

5.4.3 Propiedades básicas

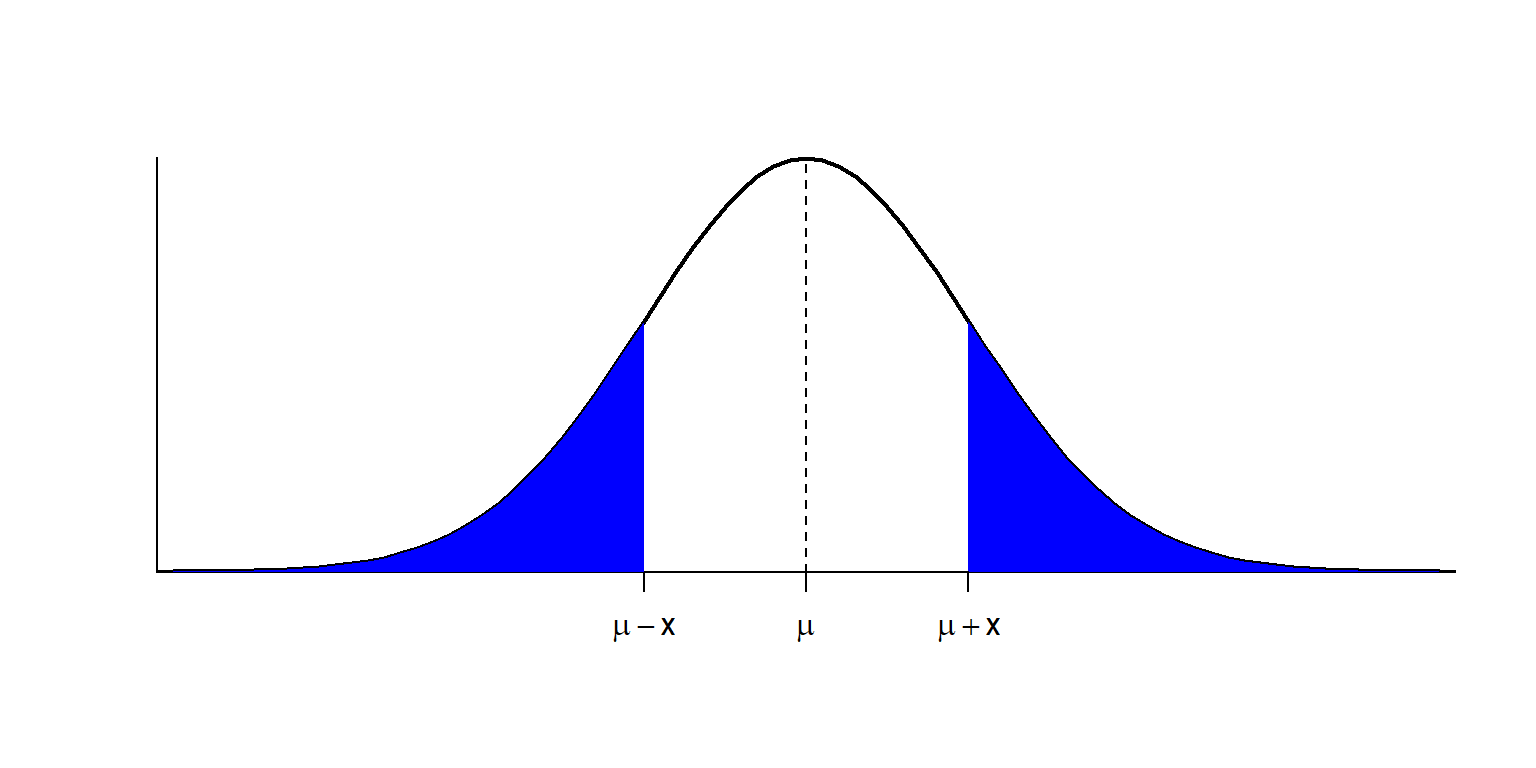

Una de las propiedades clave de la distribución normal es la simetría de la campana de Gauss:

Si \(X\) es \(N(\mu,\sigma)\), su densidad \(f_X\) es simétrica respecto de \(\mu\), es decir, \[ f_{X}(\mu-x)=f_{X}(\mu+x), \] y tiene el máximo en \(x=\mu\). Decimos entonces que \(\mu\) es la moda de \(X\).

Recordad que no tiene sentido definir la moda de una variable continua \(X\) como el valor \(x_0\) tal que \(P(X=x_0)\) sea máximo, porque \(P(X=x)=0\) para todo \(x\in \mathbb{R}\). Se define entonces la moda de una variable continua \(X\) como el valor (o los valores) \(x_0\) tal que \(f_X(x_0)\) es máximo. Así, como \(f_X(x_0)\) mide la probabilidad de que \(X\) valga aproximadamente \(x_0\), la moda de \(X\) es el valor cerca del cual es más probable que caiga el valor de \(X\).

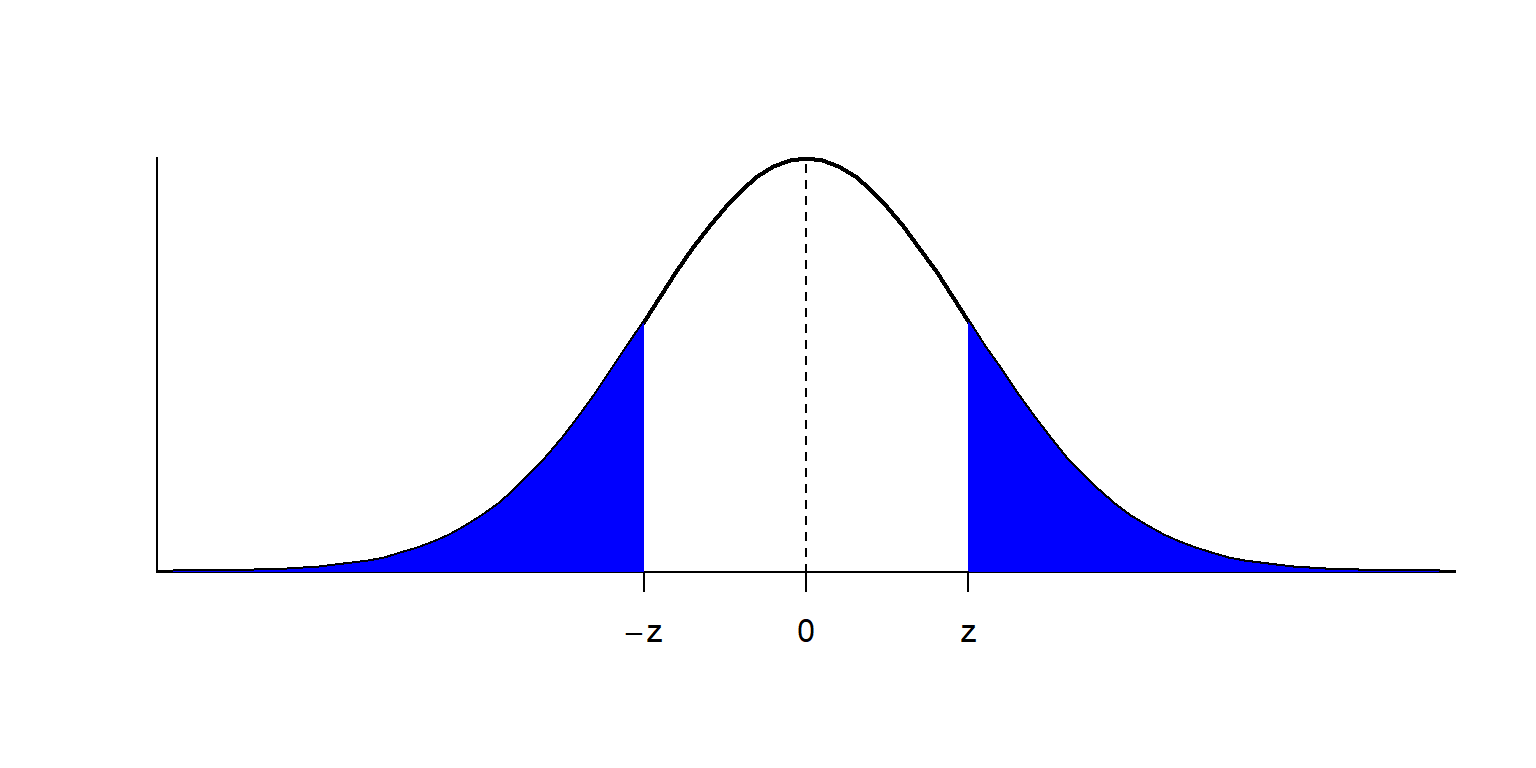

En particular, si \(Z\) es \(N(0,1)\), entonces \(f_Z\) es simétrica alrededor de 0, es decir, \(f_{Z}(-x)=f_{Z}(x)\), y la moda de \(Z\) es \(x=0\).

Recordad que la función de distribución de una variable aleatoria continua \(X\), \[ F_X(x)=P(X\leqslant x) \] es el área comprendida entre la densidad \(y=f_X(x)\) y el eje de abscisas a la izquierda de \(x\).

Entonces, la simetría de \(f_X\) alrededor de \(\mu\) hace que, para todo \(x\geqslant 0\), las áreas a la izquierda de \(\mu-x\) y a la derecha de \(\mu+x\) sean iguales.

Es decir, \[ P(X\leqslant \mu-x)=P(X\geqslant \mu+x)=1-P(X\leqslant \mu+x) \]

En particular (tomando \(x=0\)) \[ P(X\leqslant \mu)=1-P(X\leqslant \mu)\Rightarrow P(X\leqslant \mu)=0.5 \] y por lo tanto, \(\mu\) es también la mediana de \(X\).

Si \(X\) es \(N(\mu,\sigma)\), \(\mu\) es la media, la mediana y la moda de \(X\).

En el caso concreto de la normal estándar \(Z\), para cualquier \(z\geqslant 0\) se tiene que las áreas a la izquierda de \(-z\) y a la derecha de \(z\) son iguales \[ P(Z\leqslant -z)=P(Z\geqslant z)=1-P(Z\leqslant z) \] y la mediana de \(Z\) es 0.

Ahora que sabemos más cosas de la normal, en el Ejemplo anterior nos hubiéramos podido ahorrar la mitad del trabajo. Llamemos \(X\) a la variable aleatoria que nos da la presión arterial, en mm Hg, de un hombre de entre 16 y 24 años. Nos dicen que \(X\) es \(N(124,13.7)\).

Por la simetría de \(X\) alrededor de \(\mu=124\), si escribimos el 0.05-cuantil como \(124-x\), entonces \(P(X\geqslant 124+x)=P(X\leqslant 124-x)=0.05\) y por lo tanto \(P(X\leqslant 124+x)=1-P(X\geqslant 124+x)=0.95\), es decir, \(124+x\) será el 0.95-cuantil de \(X\).

El 0.05-cuantil ha sido 101.5. Escribiendo \(101.5=124-x\), obtenemos \(x=22.5\). Por lo tanto, el 0.95-cuantil tiene que ser \(124+22.5=146.5\).

Lo mismo pasa con el 0.9-cuantil y el 0.1-cuantil, razonadlo y comprobadlo.

El argumento que hemos desarrollado en la nota anterior muestra en general que si \(X\) es \(N(\mu,\sigma)\) y su \(q\)-cuantil es \(\mu-x\), entonces su \((1-q)\)-cuantil es \(\mu+x\).

Si \(\mu\) crece, desplaza a la derecha el máximo de la densidad, y con él toda la curva.

Si \(\sigma\) crece, la curva se aplana: al aumentar la desviación típica, los valores se dispersan y se alejan más del valor medio.

El gráfico siguiente muestra el efecto combinado:

Denotaremos por \(z_q\) el \(q\)-cuantil de una variable normal estándar \(Z\). Es decir, \(z_q\) es el valor tal que \(P(Z\leqslant z_q)=q\).

Aparte de que \(z_{0.5}=0\) (la mediana de \(Z\) es 0), hay dos cuantiles más de la normal estándar \(Z\) que os conviene recordar:

\(z_{0.95}=1.64\); es decir, \(P(Z\leqslant 1.64)=0.95\) y por lo tanto \(P(Z\leqslant -1.64)=P(Z\geqslant 1.64)=0.05\) y \[ P(-1.64\leqslant Z\leqslant 1.64)=0.9. \]

\(z_{0.975}=1.96\); es decir, \(P(Z\leqslant 1.96)=0.975\) y por lo tanto \(P(Z\leqslant -1.96)=P(Z\geqslant 1.96)=0.025\) y \[ P(-1.96\leqslant Z\leqslant 1.96)=0.95. \]

Muy a menudo el valor 1.96 de \(z_{0.975}\) se aproxima por 2. Tenéis permiso para hacerlo cuando no dispongáis de medios (R, aplis de móvil) para calcular cuantiles o cuando tengáis que hacer algún cálculo “a ojo” que involucre este cuantil.

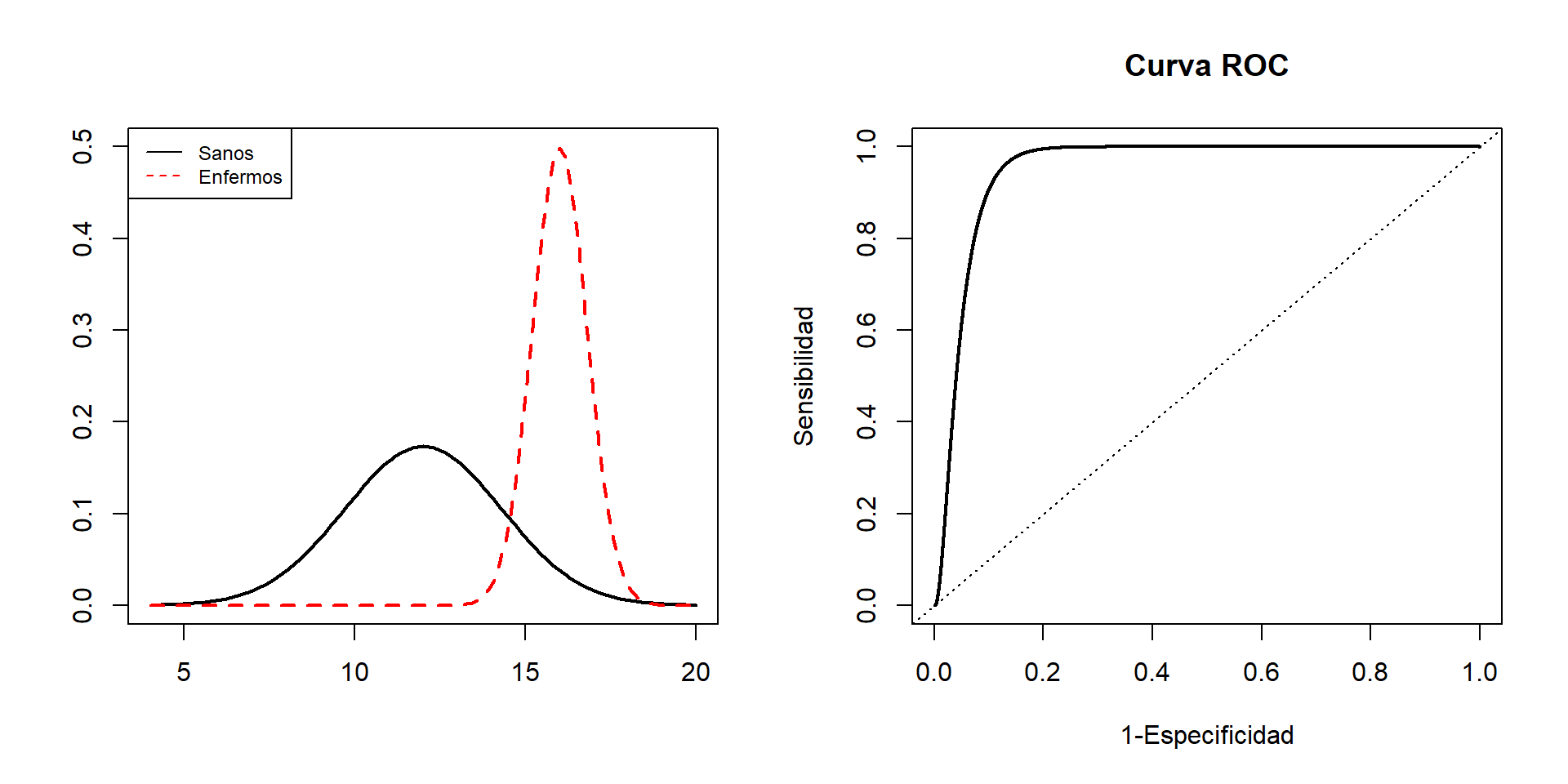

Supongamos que la concentración de un cierto metabolito es una variable aleatoria de distribución normal, pero cuyos parámetros \(\mu\) y \(\sigma\) dependen de si la medimos en personas sanas o en personas con una cierta enfermedad. Sean:

\(X_E\) la variable aleatoria “Tomo una persona enferma y mido su concentración de este metabolito”, y supongamos que es \(N(\mu_E, \sigma_E)\).

\(X_S\) la variable aleatoria “Tomo una persona sana y mido su concentración de este metabolito”, y supongamos que es \(N(\mu_S, \sigma_S)\).

Supongamos, para fijar ideas, que \(\mu_E>\mu_S\): la concentración media de este metabolito en los enfermos es más alta que en las personas sanas.

Podríamos usar como prueba diagnóstica de la enfermedad la concentración del metabolito. Para cada valor de referencia \(x_0\), nuestra prueba dará:

Positivo, si la concentración es mayor o igual que \(x_0\).

Negativo, si la concentración es menor que \(x_0\).

Entonces:

La sensibilidad de esta prueba es \[ P(+|E) =P(X_E\geqslant x_0)=1-P(X_E< x_0)=1-F_{X_E}(x_0) \]

Su especificidad es \[ P(-|S)=P(X_S< x_0)=F_{X_S}(x_0) \]

Su tasa de falsos positivos es \[ P(+|S)=P(X_S\geqslant x_0)=1-F_{X_S}(x_0) \]

Al variar \(x_0\), tenemos valores diferentes de la sensibilidad y la tasa de falsos positivos. Entonces, podemos dibujar su curva ROC y escoger el umbral con algún criterio o valorar su capacidad diagnóstica global con su AUC.

Por ejemplo, imaginad que la densidad de \(X_E\) es la línea discontinua del gráfico de la izquierda de la figura siguiente y la de \(X_S\) la línea continua. Ambas son normales y \(\mu_E>\mu_S\), porque el pico de la densidad de \(X_E\) está a la derecha del de \(X_S\).

Si para cada \(x\) dibujamos los puntos \((1-F_{X_S}(x),1-F_{X_E}(x))\), obtenemos la curva ROC de la derecha de dicha figura.

Ejercicio: Del gráfico de las densidades de \(X_E\) i \(X_S\), ¿podéis deducir cuál tiene mayor desviación típica?

Tenemos también el resultado siguiente:

Teorema: Las variables normales tienen coeficientes de asimetría y de curtosis 0.

Una de las propiedades de la distribución normal que nos facilitan mucho la vida es que toda combinación lineal de variables aleatorias normales independientes es normal. En concreto, tenemos los resultados siguientes:

Teorema: Sea \(X\) una variable \(N(\mu,\sigma)\).

Para todos \(a,b\in \mathbb{R}\), \(aX+b\) es \(N(a\mu+b,|a|\cdot\sigma)\).

En particular, la tipificada de \(X\) \[ Z=\dfrac{X-\mu}{\sigma} \] es \(N(0,1)\).

Más en general:

Teorema: Si \(X_1,\ldots,X_n\) son variables aleatorias normales independientes, cada \(X_i\) de tipo \(N(\mu_i,\sigma_i)\), y \(a_1,\ldots,a_n,b\in \mathbb{R}\), entonces \(a_1X_1+\cdots +a_nX_n+b\) es \(N(\mu,\sigma)\) con \[ \mu=a_1\mu_1+\cdots +a_n\mu_n+b,\ \sigma=\sqrt{a_1^2\sigma^2_1+\cdots +a_n^2\sigma^2_n} \]

Que toda combinación lineal de variables normales vuelva a ser del mismo tipo, es decir, normal, es una propiedad muy útil de las variables normales que pocas familias de distribuciones comparten. Por ejemplo, si \(X\) es una variable binomial \(B(n,p)\) con \(p\neq 0\), la variable \(2X\) no es binomial, porque solo toma valores pares, mientras que una variable binomial \(B(m,q)\) ha de poder tomar todos los valores entre 0 y \(m\).

Las probabilidades de la normal tipificada determinan las de la normal original, porque si \(X\) es \(N(\mu,\sigma)\): \[ \begin{array}{rl} P(a\leqslant X\leqslant b)\!\!\!\!\! & \displaystyle =P\Big( \frac{a-\mu}{\sigma}\leqslant \frac{X-\mu}{\sigma}\leqslant \frac{b-\mu}{\sigma}\Big)\\ & \displaystyle =P\Big(\frac{a-\mu}{\sigma}\leqslant Z\leqslant \frac{b-\mu}{\sigma}\Big) \end{array} \] Esto sirve para deducir fórmulas, y vuestros padres lo usaban para calcular probabilidades (con tablas de probabilidades de la normal estándar); ahora es más cómodo usar una aplicación del móvil.

5.4.4 Intervalos de referencia

Un intervalo de referencia del \(Q\%\) para una variable aleatoria \(X\) es un intervalo \([a,b]\) tal que \[ P(a\leqslant X\leqslant b)=Q\%(=Q/100). \] Es decir, un intervalo de referencia del \(Q\%\) para \(X\) es un intervalo que contiene los valores de \(X\) del \(Q\%\) de los sujetos de la población.

Por ejemplo, hemos visto en la sección anterior que [-1.64,1.64] y [-1.96,1.96] son intervalos de referencia del 90% y del 95%, respectivamente, para una variable normal estándar \(Z\). Y en el Ejemplo @ref(exm:exhiperhipo) hemos visto que un intervalo de referencia del 90% para la presión sistólica de los hombres de 16 a 24 años, medida en mm Hg, es [101.5,146.5].

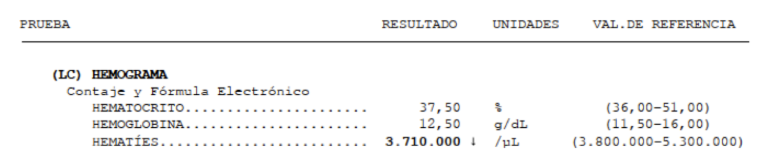

Los más comunes son los intervalos de referencia del 95%, que satisfacen que \[ P(a\leqslant X\leqslant b)=0.95 \] y son los, que por ejemplo, os dan como valores de referencia en las analíticas:

Cuando se habla de un intervalo de referencia sin dar la probabilidad, se sobreentiende siempre que es el intervalo de referencia del 95%.

Un 5% de la población está fuera del intervalo de referencia del 95%, por definición.

Cuando \(X\) es \(N(\mu,\sigma)\), estos intervalos de referencia se toman siempre centrados en la media \(\mu\), es decir, de la forma \([\mu-\text{algo},\mu+\text{algo}]\). Para calcularlos se usa el resultado siguiente:

Teorema: Si \(X\) es \(N(\mu,\sigma)\), un intervalo de referencia del \(Q\%\) para \(X\) es \[ [\mu- z_{(1+q)/2}\cdot \sigma, \mu+ z_{(1+q)/2}\cdot \sigma] \] donde \(q=Q/100\) y \(z_{(1+q)/2}\) denota el \((1+q)/2\)-cuantil de la normal estándar \(Z\). Se suele escribir \[ \mu\pm z_{(1+q)/2}\cdot \sigma. \]

En efecto: \[ \begin{array}{l} P(\mu-x\leqslant X\leqslant \mu+x)=q\\ \qquad \Longleftrightarrow \displaystyle P\Big(\frac{\mu-x-\mu}{\sigma}\leqslant \frac{X-\mu}{\sigma}\leqslant \frac{\mu+x-\mu}{\sigma}\Big)=q\\ \qquad \Longleftrightarrow \displaystyle P(-x/{\sigma}\leqslant Z\leqslant {x}/{\sigma})=q\\ \qquad \Longleftrightarrow \displaystyle P(Z\leqslant {x}/{\sigma})-P(Z\leqslant -{x}/{\sigma})=q\\ \qquad \Longleftrightarrow \displaystyle P(Z\leqslant {x}/{\sigma})-P(Z\geqslant {x}/{\sigma})=q\\ \qquad \text{(por la simetría de $f_Z$ alrededor de 0)}\\ \qquad \Longleftrightarrow \displaystyle P(Z\leqslant {x}/{\sigma})-(1-P(Z\leqslant {x}/{\sigma}))=q\\ \qquad \Longleftrightarrow \displaystyle 2P(Z\leqslant {x}/{\sigma})=q+1\\ \qquad \Longleftrightarrow P(Z\leqslant {x}/{\sigma})=(1+q)/2\\ \qquad \Longleftrightarrow x/\sigma= z_{(1+q)/2}\\ \qquad \Longleftrightarrow x=z_{(1+q)/2}\cdot \sigma \end{array} \]

Si \(q=0.95\), entonces \((1+q)/2=0.975\) y \(z_{0.975}=1.96\). Por lo tanto, el intervalo de referencia del 95% para una variable \(X\) normal \(N(\mu,\sigma)\) es \[ \mu\pm 1.96\sigma. \] Y como este 1.96 a menudo se aproxima por 2, el intervalo de referencia del 95% se simplifica a \[ \mu\pm 2\sigma. \] Esto dice, básicamente, que

Ejemplo:si una población sigue una distribución normal \(N(\mu,\sigma)\), alrededor del 95% de sus individuos tienen su valor de \(X\) a distancia como máximo \(2\sigma\) (“a dos sigmas”) de \(\mu\). El 5% restante de distribuye a partes iguales a ambos lados del intervalo: un 2.5% por encima de su extremo superior y un 2.5% por debajo de su extremo inferior.

Según la OMS, las alturas (en cm) de las mujeres europeas de 18 años siguen una ley \(N(163.1,18.53)\). ¿Cuál es el intervalo de alturas centrado en la media que contiene a la mitad las europeas de 18 años?

Fijaos en que, si llamamos \(X\) a la variable aleatoria “Tomo una mujer europea de 18 años y mido su altura en cm”, lo que queremos saber es el intervalo centrado en su media tal que la probabilidad de que la altura de una europea de 18 años escogida al azar pertenezca a este intervalo sea 0.5. Es decir, el intervalo de referencia del 50% para \(X\).

Nos dicen que \(X\) es \(N(163.1,18.53)\). Si \(q=0.5\), entonces \((1+q)/2=0.75\) y si calculamos el 0.75-cuantil de una normal estándar, da \(z_{0.75}=0.6745\).

Por lo tanto, es el intervalo \(163.1\pm 0.6745\cdot 18.53\). Redondeando a mm, \([150.6, 175.6]\). Esto nos dice que la mitad de las mujeres europeas de 18 años miden entre 150.6 y 175.6 cm. De la otra mitad, la mitad (es decir un cuarto del total) miden menos de 150.6 cm y la otra más de 175.6 cm.

El z-score (z-valor, z-puntuación, z-puntaje…) de un valor \(x_0\in \mathbb{R}\) respecto de una distribución \(N(\mu,\sigma)\) es \[ \frac{x_0-\mu}{\sigma} \]

Es decir, el z-score de \(x_0\) es el resultado de “tipificar” \(x_0\) en el sentido del Teorema @ref(thm:comblinnormals).

Si la variable poblacional es normal, cuanto mayor es el valor absoluto del z-score de \(x_0\), más “raro” es \(x_0\); el signo nos dice si es más grande o más pequeño que el valor esperado \(\mu\).

Ejemplo:Recordad que, según la OMS, las alturas de las mujeres europeas de 18 años siguen una ley \(N(163.1,18.53)\). ¿Cuál sería el z-score de una jugadora de baloncesto de 18 años que midiera 191 cm?

Sería \[ \frac{191-163.1}{18.53}=1.5 \]

Esto se suele leer diciendo que la altura de esta jugadora está 1.5 sigmas por encima de la media (donde, recordad, “sigma” es una abreviatura de “desviación típica poblacional”).